向量数据库,不只是「大模型的海马体」——对话Zilliz创始人星爵

By 出海相对论 on 2024-07-23

前言

1.webp

1.webp

数据,是数字时代的石油。

根据 IDC 预测:到2025年,全球数据总量中将有超过80%的数据是非结构化数据。向量数据是非结构化数据的抽象数学表达,向量数据库顾名思义就是专门处理向量数据的数据库。

众所周知,AI 三要素包括:算力、算法和数据。向量数据库作为一种专门用于存储和检索向量数据的数据库系统,是将非结构化数据转化为机器可以理解的语义的关键所在。随着AI 尤其是大模型技术的快速发展向量数据库的价值也愈发凸显了出来。

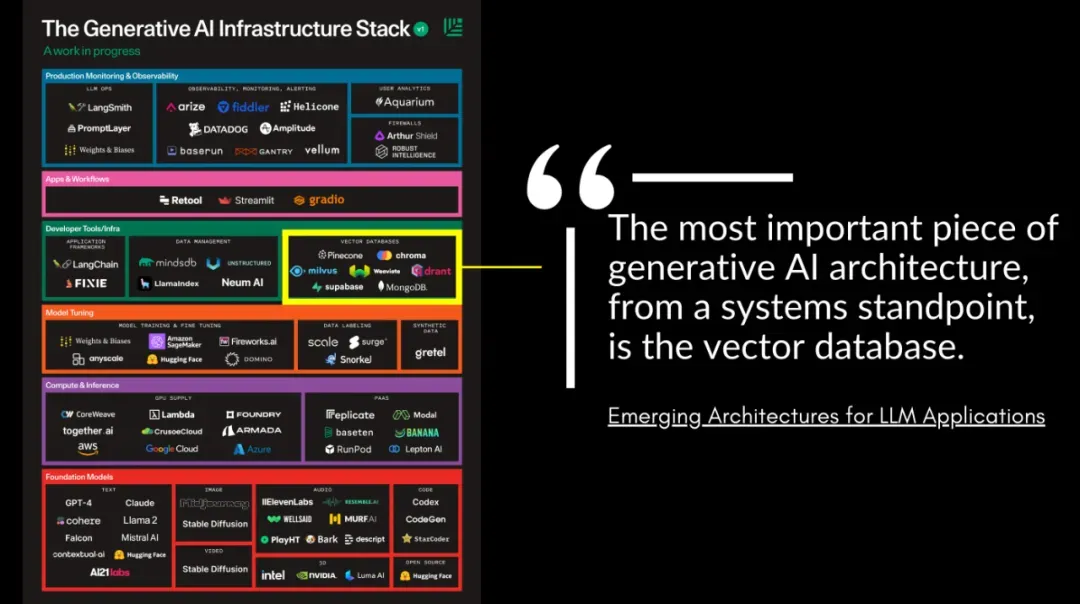

红杉美国发布的著名博客《生成式AI第二幕》和 A16Z发布的《LLM应用的新兴架构》两篇文章中一致提智能基础设施。A16Z 甚至认为:从系统的角度来看,预处理管道中最重要的部分就是向量数据库。

根据市场研究机构MarketsandMarkerts 预测:2023年-2028年,全球向量数据库市场规模预计将从15亿美元增长到43亿美元,预计年复合增长率为23.3%。

当然,在极速变化的科技行业中,预测总是落后于市场的。回顾过去数十年的科技发展史,我们可以发现:每一代新技术架构的出现都预示着数据范式的改变,也会催生出多家百亿甚至千亿级美金数据平台的诞生。AI时代的到来,向量作为机器理解世界的数据形式,也可能会让向量数据库成为新的重要基建,由此也会诞生AI时代的大型数据库公司。

今天我们有幸邀请到的嘉宾,就是全公司,也是最被广泛采用的全球领先的向量数据库厂商之一 -- Zilliz的创始人兼 CEO 星爵,请他和我们深入聊聊向量数据库、AI、RAG、开源、全球化等话题。

*本文是「出海相对论」第十五期文字版,略有删改,搭配音频食用效果更佳。文章较长,超32000字,有向量数据库相关技术全览,也有全球领先科技创业公司的行业本质思考和全球化最佳实践。

大纲 & 话题

Zilliz 与英伟达、OpenAI、Intel 等建立官方合作伙伴关系背后的故事

Oracle 的经历对创立 Zilliz 有什么影响?当时看到了什么机会?

向量数据库最被低估和高估的各是什么?

向量数据库如何解决大模型幻觉问题?是否是目前最佳方案?

Milvus 2.4版本实现了哪些技术创新,如何做到较以往50倍性能提升?

为什么一开始就选择开源?如何看待开源的价值?

Zilliz Cloud 作为云服务产品,面对不同类型客户如何平衡易用性和企业级需求?

为什么和云服务 bundling 是 Zilliz 唯一的商业模式?向量数据库能否向上/向下延伸?

面对愈发激烈的向量数据库市场竞争,Zilliz 将如何保持领先、构建壁垒?

Zilliz 在全球化发展方面有什么经验和策略?AI 时代中国创业者如何走向世界?

Long-context 长上下文的发展对向量数据库有何影响?

Transformer 遵循的冯·诺依曼架构未来可能颠覆吗?对向量数据库的影响是什么?

向量数据库的想象空间有多大?是否有颠覆传统数据库巨头的机会?

极客范+浪漫主义的文化对企业创新和发展有什么价值?

Jay:欢迎来到全新对话类出海中文播客——出海相对论。大家好,我是Jay。

佳芮:大家好,我是佳芮。

Jay:本期我们的话题是向量数据库。数据,是数字时代的石油。根据 IDC 的预测:到2025年,全球数据总量中将有超过80%的数据是非结构化数据。向量数据是非结构化数据的抽象数学表达,向量数据库顾名思义就是专门处理向量数据的数据库。

IDC 预测地址:

https://www.forbes.com/sites/forbestechcouncil/2022/02/03/the-unseen-data-conundrum/?sh=4880bfa87fcc

众所周知,AI 三要素包括:算力、算法和数据。向量数据库作为一种专门用于存储和检索向量数据的数据库系统,是将非结构化数据转化为机器可以理解的语义的关键所在。随着 AI 尤其是大模型技术的快速发展,向量数据库的价值也愈发凸显了出来。

红杉美国发布的著名博客《生成式 AI 第二幕(Generative AI’s Act Two)》和 A16Z 发布的《LLM 应用的新兴架构(Emerging Architectures for LLM Applications)》两篇文章中一致提到:向量数据库是重要的生成式人工智能基础设施。A16Z 甚至认为:从系统的角度来看,预处理管道中最重要的部分就是向量数据库。

红杉美国博客:

https://www.sequoiacap.com/article/generative-ai-act-two/

A16Z 博客:

https://a16z.com/emerging-architectures-for-llm-applications/

2.webp

2.webp

根据市场研究机构 MarketsandMarkerts 预测:2023年-2028年,全球向量数据库市场规模预计将从15亿美元增长到43亿美元,预计年复合增长率为23.3%。

市场预测地址: https://www.marketsandmarkets.com/Market-Reports/vector-database-market-112683895.html

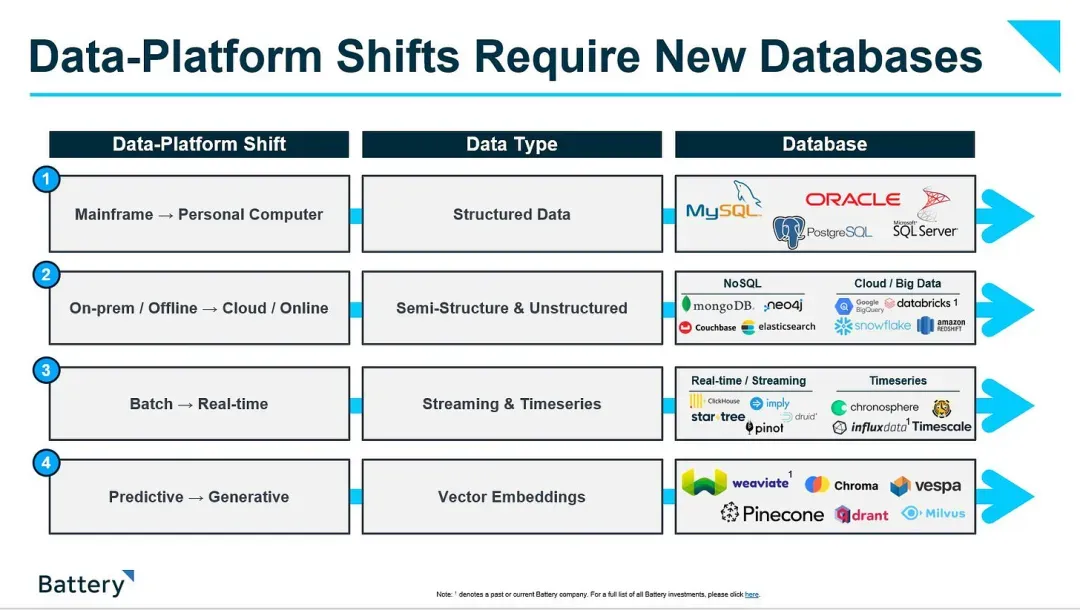

当然,在极速变化的科技行业中,预测总是落后于市场的。回顾过去数十年的科技发展史,我们可以发现:每一代新技术架构的出现都预示着数据范式的改变,也会催生出多家百亿甚至千亿级美金数据平台的诞生。

从大型计算机到个人计算机的转变导致了结构化数据的兴起,从而催生了 Oracle、MySQL 等关系型数据库;互联网和移动互联网导致云应用程序产生的非关系数据量爆炸式增长,从而催生了 MongoDB、Elasticsearch 等 NoSQL 数据库;而企业内部「大数据」的出现则催生了用于存储、管理和分析大量结构化和半结构化数据的云数据库,并产生了 Snowflake、Databricks 等云原生数据库。

AI 时代的到来,向量作为机器理解世界的数据形式,也可能会让向量数据库成为新的重要基建,理论上也会诞生 AI 时代的大型数据库公司。

今天我们有幸邀请到的嘉宾,就是全球第一家提供开源向量数据库产品的公司,也是最被广泛采用的全球领先的向量数据库厂商之一 —— Zilliz 的创始人兼 CEO 星爵,请他和我们深入聊聊向量数据库、AI、RAG、开源、全球化等话题。

星爵是一位拥有超过20年经验的数据库专家,2020-2021年担任过 Linux 旗下基金会 LF AI & Data 董事会主席。在创办 Zilliz 之前,星爵在 Oracle 美国总部工作多年,负责 Oracle 关系型数据库系统研发,是 Oracle 12c 云数据库项目的创始工程师。

在刚过去不久的英伟达 2024 GTC 大会上,Zilliz 发布了和英伟达合作的最新成果—— Milvus 2.4版本,首次采用英伟达 GPU 高效并行处理能力和最新技术,提供基于 GPU 的向量索引和搜索加速能力。基准测试显示,与之前市面上最先进的基于 CPU 处理器的 HNSW 索引技术相比,新版 GPU 加速 Milvus 能提供高达50倍的向量搜索性能提升。

我们先回到惯例,请星爵和大家打个招呼,也简单介绍下自己和 Zilliz 这家公司。

星爵:大家好,我是 Zilliz 的星爵,很开心今天能够跟大家交流。刚才主持人也介绍过了,其实我更加愿意定位自己是一个有多年经验的数据库工程师,或者说我给自己的定义应该是个 lifetime database engineer。

七年前我们创立了 Zilliz,Zilliz 是全球第一家向数据库公司,现在也是全球最被广泛采用的向量数据库 Milvus 背后原创的公司。在过去几年,我们见证了 AI 的发展,也见证了向量数据库的发展。

在过去的几年里,我们向量数据库的产品被全球超过 5000 家企业采用,全球的安装下载量也超过了 2500 万,现在这个数字还在急剧地增长。

今天很开心能够跟大家一起交流,一起去探索向量数据库、非结构化数据和 AI 的未来。

Jay:先从刚才提到的和英伟达的合作开始聊。在今年的英伟达 GTC 大会上,你们发布了和英伟达最新的合作成果 ——Milvus 2.4 版,可以实现较以往50倍的向量搜索性能提升。包括你还有另外两位 Zilliz 的高层也都在这次 GTC 大会上进行了线下和线上的分享。

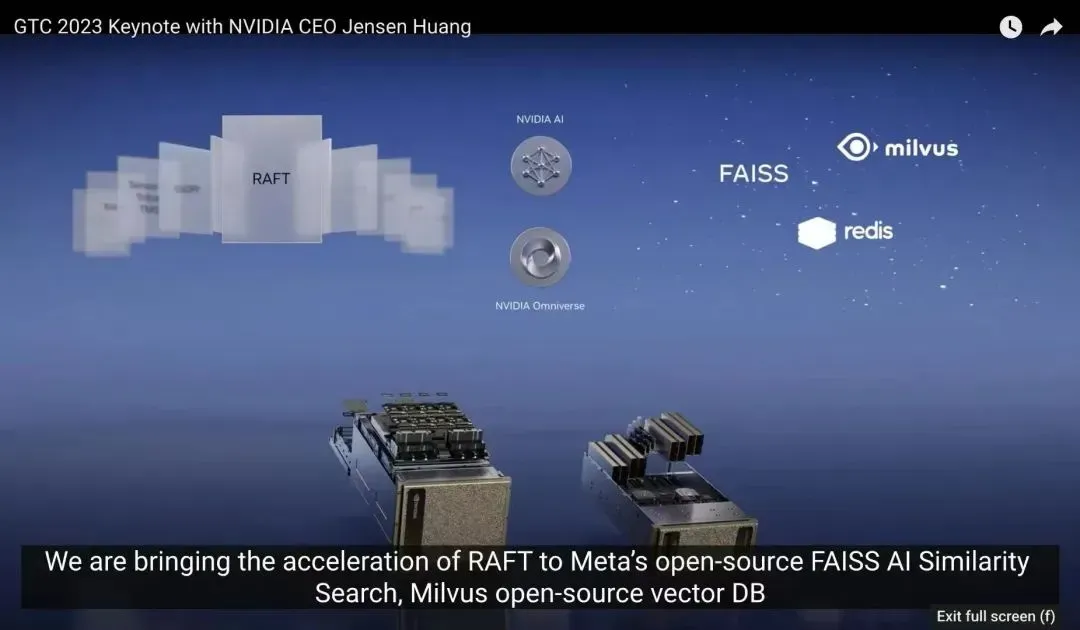

其实在去年的 GTC 大会上,英伟达创始人黄仁勋就首次介绍了向量数据库并且专门点名了 Zilliz 的产品 Milvus 作为英伟达的官方向量数据库合作伙伴;然后去年 OpenAI 发布 Plugins 的时候也专门介绍了 Zilliz 是他们的官方合作伙伴。

3.webp

3.webp

包括在刚过去不久的今年4月的 Intel Vision 2024 大会上,Intel 推出了最新的 Gaudi 3 AI 加速器,同时还宣布了自己正在与多家企业合作创建 AI 开放平台,Zilliz 就是首批合作伙伴之一,你也在大会现场进行了圆桌分享。虽然 Intel 就目前来看在这轮 AI 技术浪潮中有点掉队了,但我们都知道 Intel 是全球芯片产业的领袖、老大哥,是硅谷的奠基企业之一,实力依然是毋庸置疑的。

Intel Vision:

https://www.intel.com/content/www/us/en/events/on-event-series/vision.html

Gaudi 3:https://www.intel.com/content/www/us/en/products/details/processors/ai-accelerators/gaudi3.html

4.webp

4.webp

除了刚才提到的这些,打开 Zilliz 的官网还可以看到包括微软、谷歌、亚马逊等都是 Zilliz 的官方合作伙伴。能够被全球最顶尖的 AI 领军企业们认可,除了说明 Zilliz 产品的卓越性能和影响力,也代表了 Zilliz 在构建生态与合作伙伴关系上强大的实力。能否简单跟大家聊一聊:

Q1:Zilliz 与英伟达、OpenAI、Intel 等建立官方合作关系背后的故事

星爵:其实背后没有特别复杂的故事,我们之所以做这些事情,一切都是希望以开发者的需求为中心,去帮他们构建一个更加易用、更加简便的生态系统。

所以比如我们跟这些大模型厂商包括 OpenAI、Cohere、HuggingFace,还有国内的智谱AI、MiniMax 等合作,就是希望帮助这些 AIGC 的应用开发者能够更加简便地去搭建他们自己的私有知识库,去搭建他们的 RAG 应用。

我们跟英特尔合作,是因为发现我们大概有95%以上的开发者,他们的工作负载是跑在英特尔的 CPU 之上的,所以提升效率对他们来说是特别重要的一件事情。所以在过去几年,我们跟英特尔的团队一直在合作,把向量数据库在英特 CPU 上的执行效率提升了上百倍。这意味着他们以前可能需要10台甚至100台服务器才能完成的一个负载,现在可能用一台甚至几台服务器就能够做好。

包括英伟达的合作也是从用户出发。我们知道传统来说英伟达可能是在训练端有很大的场景,但是我们最近几年发现在数据端的一些挑战,可能也需要这种新兴的硬件去加速。比如说有些应用场景需要在向量数据库里面有特别高的查询效率,需要有很高的 QPS(Queries Per Second 每秒查询数,QPS = 并发量 / 时间(秒),QPS 是衡量服务器在特定时间内处理查询流量的一个重要指标)。在这种时候,如果用 GPU 加速能够得到比 CPU 更高的性价比。我们做过一些评测,性价比甚至能够提升50-100倍。

所以从我们的观点出发,做这些合作都是希望能够为我们的开发者,为我们的用户提供一个更加易用、更加经济、更加高性能、更加低成本的解决方案。

Jay:回到向量数据库,我们先简单回顾一下近十年向量数据库的发展史。

近十年,深度神经网络的快速发展促进了向量数据库的发展。2015-2016年,Google 和微软发布了标志性的相关论文;2017年,Facebook 开源了 Faiss 框架(Zilliz 也是在2017年成立的);2019年开始出现了独立的向量数据库(Milvus 的开源第一版发布时间也在2019年),当时也出现了基于 Faiss 的向量数据库。与此同时,向量数据库开始被更加广泛地应用于自然语言处理、计算机视觉、推荐系统等领域。

接下来的事情大家应该都知道了,2022年11月底 ChatGPT 发布,大模型时代来临。随着大模型的爆火,向量数据库因具备帮助大模型更新数据、构建知识库、消除幻觉等显著能力开始受到各界追捧,直到现在。

正如我们开头所说,在创办 Zilliz 之前,你是 Oracle 的数据库系统工程师,构建了全球领先的关系型数据库 Oracle 12c 的早期版本。之后你离开 Oracle 并在2017年创办了 Zilliz。

你的故事让我想起了 Oracle 的诞生过程。1977年,拉里·埃文森在一家叫 Omex 的公司给中央情报局做数据库项目,偶然读到了一篇文章,是当时 IBM 的研究员,后来的「关系数据库之父」埃德加·科德(Edgar Codd)在 IBM 的杂志《研究与开发》上发表的一篇论文叫《大型共享数据库数据的关系模型(A Relational Model of Data for Large Shared Data Banks)》。

论文地址:https://dl.acm.org/doi/abs/10.1145/362384.362685

这篇论文事实上也奠定了关系型数据库软件的理论基础,埃德加·科德也在1981年拿了图灵奖。

不过那时候学术背景的 IBM 研究员们并没有太在意这件事的商业化潜力,也可能因为创新者的窘境,IBM 并没有把这项技术发扬光大。但是在被拉里·埃文森发现后,他敏锐地捕捉到这件事的商业潜力,于是很快决定自己创业,才有了后来 Oracle 的故事。

我看到你曾经对外表达过:在 AI 大数据时代,非结构化的数据必然需要有一些专门的数据处理类企业来做,这就意味着将会有企业发展崛起的机会出现。能否展开讲讲这段故事,分享一下:

Q2:Oracle 的经历对创立 Zilliz 有什么影响?当时看到了什么机会?

星爵:我在思考问题的时候有一个经验,就是如果我们把很多事情拉到一个更加偏技术发展史的宏观维度去看的话,很多噪音就会消失,很多大方向、历史的脉络就更加清晰了。

虽然说我们每个人都活在当下,但是在做一些重要决定的时候,我会尽量地跳出去看看历史。如果不读历史的话,你肯定无以去知将来。

如果我们看数据库的历史,具体来讲为什么在上个世纪的70年代 Oracle 会崛起?那个时候我们可以看到其实是因为整个 IT 时代兴起,而有了大量信息化的数据。而当时的计算机可能只能够处理 0、1 这种很简单的数据,但是数据量又大到了一定程度,所以你会发现如果用传统的这种目录的方法去管理数据的话已经是很低效的了。那这个时候就催生了整个关系型数据库的理论体系,包括关系型模型、数据库设计的范式,这样就能够在消除数据冗余的情况下,还能够保证数据高效的存储和访问。

所以 Oracle 在那个时代就应运而生了,本质上是因为我们进入了 IT 时代,有大量的结构化数据需要去处理。

在过去的几十年里面,我们看到第二波的一个很大的机会,就是整个云的时代。在云的时代里面,我们又见证了另外一个数据库巨头—— Snowflake 的崛起。本质上来说 Snowflake 是属于结构化数据处理,也基本上是属于关系型数据的模型,但是它的崛起是因为整个数据库的使用和安装方式发生了变化,从私有部署到了云。

随着公有云的崛起,有了一种全新的数据库部署和分发方式,以及与此相关联的商业模式的变化。Snowflake 利用这一波云的变化机会,打造了一个商业化的大帝国。

然后从2015年开始,我们看到新一波的 AI 兴起以后,有各种各样深度学习的模型和算法,有各种各样的机器能够去代替人做更加智能化的事情。所以在智能化的时代,如果去看一看数据处理的变化,我们其实会发现数据处理的范式发生了一个根本的变化。

像之前我们在 IT 时代也有智能,对不对?当时有统计学习,有机器学习,但是当时的学习对象一般是一些数字,一些字符串,基本上是结构化的数据,在关系型数据库里面去学习,基于结构化的数据去做数据分析,还有商业的决定。

但是到了2015年后进入新的 AI 时代、神经网络时代,我们发现处理的数据类型发生了很大的变化,我们处理的基本都是这种语言、文字、图片、视频、用户行为画像、地理位置信息、蛋白质的三维结构、小分子的三维结构等,还有在 AI 制药领域以及我们人类基因序列领域的数据。我们需要用新的 AI 模型,用新的深度学习的方式去理解、处理、分析这些数据,最终为我们的各种商业决策提供帮助。

刚才说的这些数据,如果我们用一个统称去概括的话,这些都是非结构化数据。

所以在 IT 时代和云时代,我们见证了两个系统性的大机会,一个是以 Oracle 为代表的关系型数据库,一个是以 Snowflake 为代表的云数据库。在 AI 时代,我们会看到非结构化数据处理跟向量数据库的兴起,这是一个必然。

5.webp

5.webp

另外向量数据库跟非结构化数据的兴起,可能意味着一个更大的机会。为什么这么说呢?因为我们知道非结构化数据的数据量是远超过结构化数据的,有各种分析报告指出,非结构化数据至少比结构化数据大一个数量级。我个人的预测是非结构化数据在未来的5-10年,它的数据量比结构化数据可能要大两到三个数量级。

因为我们现在所有的这些 AI 算法和模型,都已经是在产生非结构化数据了。大语言模型能够帮我们产生大量的文章、文本,图片生成模型能够生成大量的电脑合成的图片,然后视频的模型能生成大量 AI 生成的视频。在过去的几十年里面,我们的非结构化数据基本上是由我们人类的生产活动去产生的;而接下来因为我们有大量的机器,能够不眠不休地去帮我们产生大量的文本、图片和视频等数据。所以未来的5-10年非结构化数据会有巨大的增量。

再举个很简单的例子,比如说如果让我们自己写一篇一万字的文章,我估计反正让我写的话怎么着也得写个一两天,甚至要写一两个星期,对不对?但是如果我们给一个大语言模型确定一个主题跟提纲,你让它写,它最多可能两分钟就给你写完了,对不对?你不满意的话就再花两分钟写一篇。所以如果是两个星期那至少能够产生一万篇文章,然后你可以去选一篇出来。

所以不只是我们人作为生物体在产生非结构化数据,而我们人造出来机器也能够像我们人一样地去产生非结构化数据。所以在这个背景下,非结构化数据未来会有一个爆发。

那我们知道数据在哪里、数据量有多大,可能就会决定这个市场和产品的天花板有多高。我坚定地相信,在未来包括现在非结构化数据处理的数据库的市场是相当大的,有机会应该可以容纳下一个 Oracle、一个非结构化数据的Snowflake、一个非结构化数据的 Databricks。

另外我们看到在结构化数据处理的这个市场,其实有上百家结构化数据的公司做得都很不错。那么在非结构化数据处理这个方向,我们认为可以跑出来的公司可能会是以上百家,甚至以几百家去为计的。

佳芮:非常棒!我觉得 Charles 有历史的纵观感,历史总是在重复自己的韵律,虽然表现形式不太一样。我们刚才也听到了整个的数据从结构化到云化到今天的非结构化,经历了从 Oracle 到 Snowflake 到今天是以 Milvus 为代表的向量数据库。

前面我们聊到大模型带火了向量数据库,一时间媒体争相报道,创业者和大厂们也都跃跃欲试,云厂商、大数据公司在2023年也纷纷发布了相关产品。资本也随之火热,仅2023年4月单月全球就有5家向量数据库公司宣布融资,最高的一笔达到了1亿美金。

在一次采访中针对大家纷纷入局,你一边表示很欣慰看到大家能够涌进来参与建设和竞争,另一边你也认为市场存在泡沫,你认为「在未来的2-3年内可能会在产生几十家向量数据库公司,但也会死掉几十家向量数据库公司,因为数据库赛道其实是一个赢者通吃的市场,现在入局向量数据库赛道的新玩家,在技术积累、人员团队组建,甚至资本运作方面,都不具备相对优势。」

另一方面,关于向量数据库价值的讨论和争议也一直没有间断,比如向量数据库产品门槛不高、不值得投资等等。对此你也表达过自己的观点,你觉得:「向量数据库的门槛不高,这是一个最大的误解,向量数据库可能是人类历史上最复杂的数据库系统。」

还有一些关于向量数据库现阶段价值的事件。比如去年10月最火的 Agent 项目 AutoGPT 宣布不再使用向量数据库,再比如大家熟悉的前 OpenAI 科学家同时也是联创 Andrej Karpathy ,去年4月他用 OpenAI 的 API 建了一个大模型应用,有网友问用了什么向量数据库,他表示:人们总是追风那些「非常 fancy 的东西」,其实使用 Python 库中的 np.array 就可以实现。

6.webp

6.webp

其实我倒是觉得这些说法过于媒体化了。因为我的公司句子互动也在做 Agent 的平台,提供大模型的中间层。我们自己做了知识库和workflow,打通了不同的大模型并进行编排和调度,用户只需要导入各种非结构化文档,比如word,pdf这些,就能直接让机器人回答文档里面的内容。这里我们需要先在数据库中进行检索,再生成回复的内容,后面我们会介绍 RAG。

这里的检索其实就是从已有的数据库找到相关的数据,我们综合使用了各种数据库,我们用到了向量数据库,也用到了的「非向量数据库」 ,比如关系型数据库、非关系型数据库等等。

从我的视角看,是否选择向量数据库是场景问题,而不是一概而论地去说应该如何选择。向量数据库的优势在于语义搜索,如果有合适的策略同时使用关键词搜索并用向量补充语义搜索,就能达到精确性与上下文的平衡,同时结果也会更加全面。

所以很多东西其实都有背景,不只是说出来这么简单,更多还是说是不是在合适的场景提供了合适的价值。在价值的讨论上,在另一档采访中你被问及向量数据库的挑战,你认为最大的一个挑战是:「很多接触到向量数据库的开发者可能只是简单用了一下,还没有真正了解向量数据库的真正含义。长期来讲,他们还不理解向量数据库的价值,甚至可以说是严重低估了向量数据库的价值。」

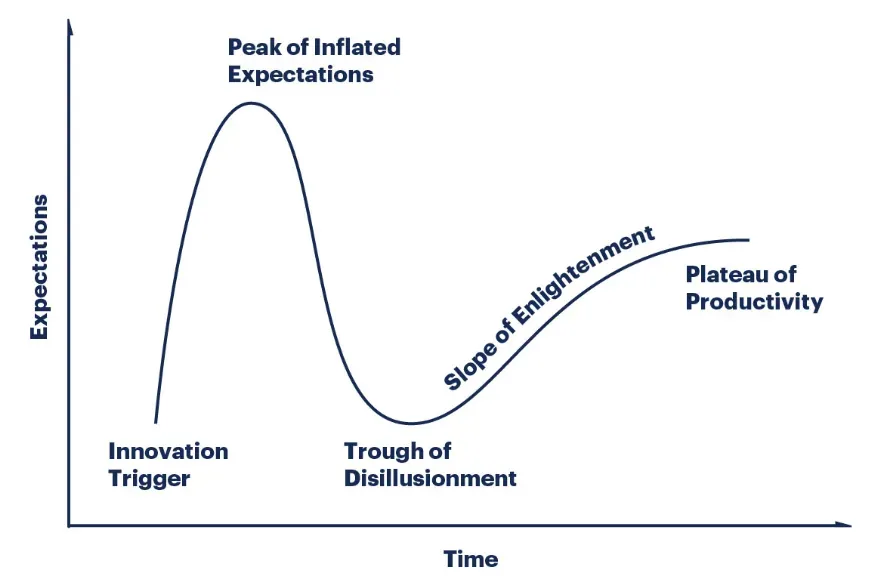

你说到低估,我就想借用一下阿玛拉定律(Amara’s Law)的说法:人们总是高估一项科技所带来的短期效益,却又低估它的长期影响。所以想请你站在前沿从业者的角度分享一下自己的观点:

Q3:向量数据库最被低估和高估的各是什么?

星爵:对于向量数据库来说的话,其实大家基本上还是达成了一个共识,就是在接下的 AI 时代一定会有一个数据库系统是为 AI 去设计的,也就是 DB(Databese) for AI,DB for AI 其实已经讲了有十多年了。而现在来说,可能大家达成的一个共识是,向量数据库可能就是那个 DB for AI 的产品。

至于说低估和高估,我个人感觉其实说不上是绝对的低估或者是高估。可能就是这个市场里面很热闹,大家也觉得这边的机会很大,所以过来凑热闹的人比较多。所以我觉得如果说高估,可能大家觉得这边比较热闹,有一个很大的 hype。

在过去的一年里面,我们估计看到了两三百家数据库的厂商,都纷纷把自己定位成向量数据库公司,这两三百家里面估计有250家以上其实都是存在了很多年的数据库厂商。

佳芮:连 Elasticsearch 都出了自己的向量数据库。

星爵:对,大家都觉得这个事情很火,也得要去做一下,好像如果不做的话,可能就赶不上这波技术的潮流了,可能很多人是有这种 FOMO(Fear of missing out,害怕错过) 的心态,对不对?

但是我觉得在喧嚣热闹的背后,其实我看到的是向量数据库是被低估的,一个最核心的原因就是大家可能没看到向量数据库还是在发展极为早期的一个阶段。它的能力的边界是被低估的,它的能力的天花板大家可能是没看到的,甚至于说它的内涵跟外延其实也是缺乏一个定义的。

可能大家最开始接触到向量数据库,就是做一些语义的模糊检索,做所谓的 ANN(Approximate Nearest Neighbor)检索,就是向量的相似性的检索。但是其实我们在今年,已经把基于关键词的检索做进了向量数据库里面,这样就比传统的基于关键词的检索能够有巨大的效率提升,还有巨大的精确度的提升。而这项技术我们叫做 SPSS Index。把 SPSS Index 跟稠密 Index 结合在一起,就可以在同一个向量空间,在同一个向量数据库的引擎里面实现精确匹配和模糊匹配。

佳芮:最新的版本已经发布了吗?我们也要试一下。

星爵:对,我们2.4版已经发布了。但是很多人现在可能还不了解向量数据库可以做精确查询,可以取代 ES(Elasticsearch),并且比 ES 有更低的成本、更高的准确性、更好的性能。

比如说之前在 ES 里面你需要去维持一个近义词的词典,这个近义词的词典如果更新不好的话,你查询的效果就不好。但是你在稀疏向量的检索里面的话,本质上后面是用大语言模型去解决了近义词,所以你根本就不用去维持近义词的词典,你用稀疏向量的算法生成向量以后,用向量数据库一查,这种近义词同义词的匹配、语义的匹配、精确的匹配就全部给你做完了,所以这是一个被低估的。

然后在向量数据库里面还有很多功能,比如说做基于向量的聚类分析,这其实也是我们在接下来的版本里面要推出的一个重要的功能。就是说你有这么多的向量数据,那你如何从里面去找到一些 pattern?而这些 pattern 对于这种我们的风控,对于欺诈检测,对于异常检测是相当重要的。之前可能大家是用一些图数据库,然后从图数据后面找到一些子图,然后用子图匹配的方法去做一些模式的发现。

现在这些都根本不需要了,你用向量数据库聚类分析的方法,就已经可以找到不管是金融的风控还是网络安全里面的模式匹配,还有异常分析的功能。并且 again,这也是用机器学习的算法,用深度学习的模型去代替人类去找到这样的 pattern,我们都知道这一块机器做得比人好,所以我们能得到更高的准确率,也有更高的性能。所以向量数据库我认为在未来的五六年里面,它的功能、性能、边界都还会有巨大的提升。

7.webp

7.webp

包括在性能和成本方面,如果说向量数据库要去处理这么大规模的非结构化数据,那么对每个企业,对每个数据拥有者来说可能都是不小的成本。而这个成本可能会潜在影响到向量数据库大规模的应用,也会影响到非结构化数据得到解析和被利用。

我们有一个预测,未来五年现在向量数据库的成本可能可以降低1000倍以上。我们也给自己定了一个小目标,就是在今年我们希望能够把向量数据库的成本至少降低10-100倍。其实我们现在已经降低10倍了,我们看看今年下半年能不能再降个10倍。而降低了10倍以后,才能让更多的企业把向量数据库拿来用。

而这些事情可能在外面的官宣和喧闹中都是看不到的,可能大家都觉得今天你这边起高楼了,今天你这边放鞭炮了,对不对?感觉挺热闹的。但是其实在水下,我们每一天都不能够松懈,因为向量数据库的企业的需求,企业对非结构化数据处理的需求是在不断地增加的,每一天都会有新的需求出来。

而向量数据库作为一个面向于非结构化数据,面向于 AI 应用的一个基础的数据设施,它如何在未来的5-10年里面跟着 AI 的应用场景,跟着开发者的需求,跟着非结构化数据的规模还有场景的增多而不断地去迭代自己,增加更多的功能,提供更好的性能,降低成本,这其实是相当难的问题。而这个问题需要的时间跨度,需要的耐心,我觉得是被低估的。

佳芮:刚刚听 Charles 说的,我也很有启发。因为我们的销售也要出去卖我们的产品,有时候会涉及向量数据库。大家首先可能不知道什么是向量化,不知道什么是向量,也不知道什么是向量数据库。我经常跟他们开玩笑说,你可以把向量化理解成是一个多维数字,理解成是一个值要往里存。

而实际上在真实的场景里我们看到的是目前现实世界里向量化的数据还不是很多。虽然我们知道非结构化的数据非常多,但是和结构化的数据比,真正在投产的过程中,除了最前沿的这些科技企业,其实在很多传统的公司里还没有把数据完全向量化。因为数据量不够大,所以大家可能以为向量数据库就只是单纯的存储。

但刚刚听下来,其实向量数据库中还可以做很多搜索的优化,包括去做性能的提升。这让我想起来比如说 MySQL,它的整个查询语句的优化其实是在过去几十年持续发展出来的,这个的价值绝对不只是说存一个库这么简单的。

我也观察到一个有意思的现象,就是刚才我们聊到 ES 在往向量数据库上走,向量数据库其实也在看能不能替换掉更多 ES。因为我们公司里边其实用了好多数据库, ES 肯定是非常依赖的,包括在所有的我们去调优的环节里边,都是拿着 ES 里边的每一步环节,看这一步出在哪,类似去做这些事情。那听起来其实两端正在往中间一点点去走。

包括刚才聊到聚类,因为我们也在用相关的,这里也想请教一下。从文本的角度来讲,抛开刚才你讲的那些场景,我们有一个很典型的场景,是我们自己用工程化去做的,就是我们的客户有大量的聊天历史信息,客户经常想知道他们都在聊什么。这是一个非常经典的需求,然后我们做了一个聚类,我们把每一条对话都做了向量化,然后去做相似值的匹配。

我们要跑好多脚本,0.97版、0.96版、 0.95版等等,因为不同的聚类的效果,最后出来的东西是不一样的。这个数值又不能做得太大,又不能做得太小,中间这个比例还挺难拿捏的,所以在每一个客户上我们都做了非常多的工程量。 所以也想请教,因为刚才你也聊到很多聚类,如果在对话的场景,我们的客户希望知道聊了什么以后,可以反向再去整理一些问答对会更精准,然后去输入一些问答对,包括去反向提供更多知识会更精准。因为我现在已经可以解决这些事了,那比如说我接下来可以不做那些工程量了吗?

星爵:对,这一块就聚类分析来说是一个特别经典的场景,它跟传统的 ANN(Approximate Nearest Neighbor,近似最近邻,一种用于处理高维数据的算法,用于在高维空间中快速找到与给定点最接近的点或一组点,但并不保证找到的是完全精确的最近邻点) 是不一样的,但是它跟 ANN 也有个比较近似的地方,都是需要构建一个比较复杂的索引算法,然后把这些类似的或者说在向量空间里面比较近的向量节点,放在比较相近的位置。

它跟 ANN 不一样的地方在于, ANN 一般是算 Top-k(指从一组数据中找出满足某种条件的前 k 个元素,k 为正整数),就是拿到 Top-k 就好了。而在聚类里面,我们要拿到的不只是 Top-k,我们可能是要拿到在这一个集群里面的所有东西,不管是有1000个,还是1万个,甚至有更多的我们都要拿到。

所以在这个场景里面,在我们的 Milvus 里面去 build 这样一个专用的算法跟一个 API 接口,用这个接口你肯定是不用像以前那样自个去做很多的尝试,去看看哪一种聚类算法会更好。因为在这里面其实有很多很多经典的算法跟研究,然后我们也把这些经典的算法跟研究做到了我们的产品能力里面去。

不管是你刚才说的要找相同的 topic,还是要找什么热点问题,还是要找异常的检测,只要你向量存在这个向量数据库里面,然后你用一两个 API 的 call,我们就可以给你拿到你想要的结果。

所以我觉得你刚才也讲了一个特别好的场景,我这里想总结一下,就是向量数据库什么时候既不被低估也不被高估呢?就是所有人都不谈论向量数据库的时候。因为如果在技术的发展过程中,我们可以看技术成熟度曲线,最开始有个 hype ,然后后面下去,然后真正创造很高的价值,再到这个技术可能会被下个技术替代,对不对?

8.webp

8.webp

我们日常生活中也是这样的,当一个东西天天被当做新闻的时候,就证明这个东西太新了,等到不被当做新闻的时候可能就人手一份了。

佳芮:对,就像我们现在天天呼吸的空气,就已经在我们的生活里边了,我们就不会再去关注它了。

我们接下来聊聊经典的幻觉问题。随着大模型的发展,很多人逐渐对其幻觉问题产生了共识:有智能就有幻觉。从我的观点看,其实正是因为大模型有幻觉,才能够有足够多的创造性。其实很多时候幻觉不一定要完全抹杀,而是要看场景以及通过一些合理的手段从外部对症下药,而不是从大模型层完全根治。

其实从某种角度说,人类的幻觉比大模型的幻觉严重的多,人类也会撒谎,也会不表达真实的想法,但是这并不影响最终大家一起把事情协同完成。

大模型的幻觉产生的原因是非常多的,有可能是因为数据训练或者模型本身的原因,另外很大一块的原因就是因为大模型没有这个知识。如果大模型没有特定领域的知识,但是用户又问到了这个问题,那大模型就会「一本正经的胡说八道」,也就是会产生幻觉。

我类比一个场景,譬如说一个小朋友明明不知道一件事,但是他还想展示自己很强很厉害,他懂这件事,那么他就会犟嘴。那针对这种情况我们要去做幻觉的消除的话,就是把知识给到他,让这个小朋友学会了,他就不会犟嘴了。大模型也一样,它知道的这个问题就不会「犟嘴」了。这就是在大模型之前先去做搜索,做了更好的搜索就可以让它再去做下一步的生成。后面我们会聊到 RAG,那中间其实用到了很多向量化的技术。

A16Z 在去年4月发的那篇文章《投资 Pinecone(Investing in Pinecone)》中开头就写道:「当前大语言模型面临的一个巨大挑战是幻觉。它们给出的答案非常自信,但事实上有时甚至在逻辑上都是错误的。」文章还提到向量数据库是大语言模型的存储层,可以通过 In-context learning、Embedding 等方式处理幻觉问题,同时优化计算和推理成本等。 投资 Pinecone:https://a16z.com/announcement/investing-in-pinecone/

这里可能大家对这个词也不是特别熟悉。用我刚刚「犟嘴」的例子继续形容:我们搜索到准确的信息,然后把这些放在提示词也就是 Prompt 中,就可以理解成他说的 「In-context learning」。而能做语义搜索的前提,就是把内容做向量化,也就是他说的「Embedding」。

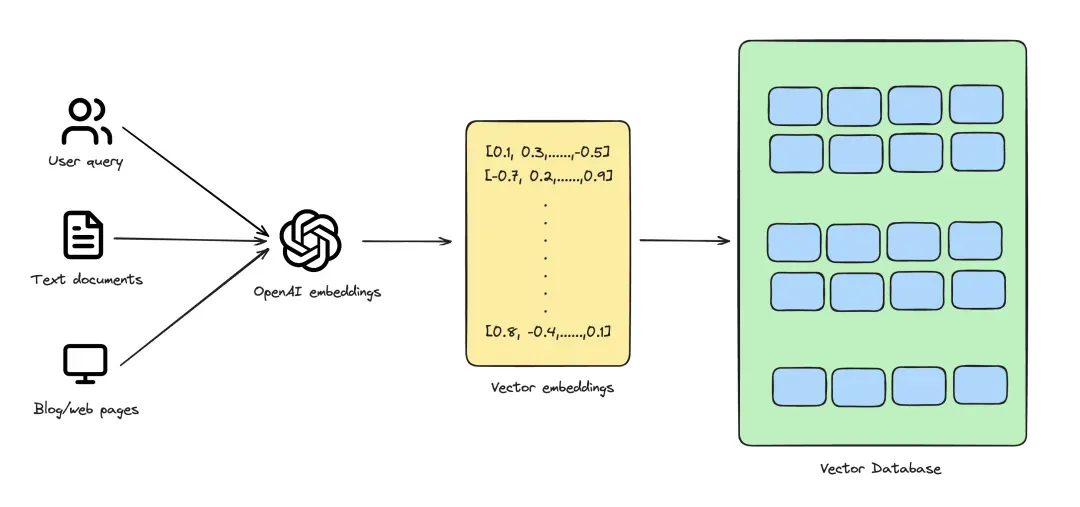

9.webp

9.webp

其实不只是存储内容的向量化,还有用户提问的向量化。最后得到各种向量以后,去计算不同的向量之间的距离,那距离越近语义就越相近,这样就能实现比较好的搜索。搜索的问题解决了,把所有的信息给到了大模型这个小朋友,那大模型就不会存在「犟嘴」的问题了。

关于向量数据库解决幻觉的这个问题,你之前也有表述,你说:「解决幻觉主要有两种方法,一种是向量数据库+Prompt,另外一种是 Fine-tune,向量数据库和 Prompt 其实是密不可分的。消除幻觉的过程是把知识库向量化以后,通过向量数据库找到相关知识点,再把相关的知识点的需求,通过 Prompt 反馈给大模型。Fine-tune 是另外一种方式,和向量数据库加上 Prompt 相比实施成本更高。」

我特别同意这个观点,其实我经常会劝我的客户不要 Fine-tune,因为 Fine-tune 除了实施成本更高,更重要的是对数据的要求更高,而大部分的公司是没有这么多高质量的数据的。这里也想请星爵展开讲讲:

Q4:向量数据库如何解决大模型幻觉问题?是否是目前最佳方案?

星爵:其实幻觉这件事情大家不要想得太复杂,这个事情其实很简单,就像是说这个人他不知道,然后他又要不懂装懂,然后他就自己觉得自己知道,就可能给你胡说八道。本质上如果他知道了,那肯定就没问题,他就不会瞎编了。

向量数据库作为一个外挂知识库,可以给大模型关于这个问题、关于这个上下文最真实的知识。在很多情况下,这些知识是大模型在训练过程中,学习过程中没有见过的、没有学到的,而我们知道大模型不能去推断它没学过、没看过的东西。

这和我们人一样,以我自己为例,我之前没有去过中国西北,别人跟我说西北有多好,我心里是没有感觉的。如果要我去描述西北,那我就可能瞎说了,对不对?当我真正去了西北以后发现那的风景真的是好,然后你再问我就不会瞎说了。很多事情你可能没见过,那么你就只能够猜测,就只能够去编造。

同样我们知道大模型是经过公有的数据去训练的,而我们有很多数据是存在于每个企业自己私有的数据库里面,存在自己私有的数据中心里面,这些数据是企业的核心资产。这些企业以前没有把这些数据交给大模型厂商去训练,可能以后更加不会。那么这些知识大模型没见过,那可能就只能去推断。

比如你问大模型,你们公司昨天开的决策会最终定的是什么方案?大模型可能有时候就跟你瞎说。但是向量数据库就能够把你们企业内部的文件,包括昨天开会的会议纪要,提供给大模型,那大模型就可以给出一个很准确的答案。 所以本质上就是向量数据库会在企业的私有知识跟大模型的知识之间去做一个桥梁,给大模型更多它自己以前没有见过、没有学习过的知识。然后如果要跟其他的方案,比如 Fine-tune 去比的话,向量数据库应该是现在最被广泛使用的方案。刚才讲过,它的成本比 Fine-tune 要低很多,可能要低一到两个数量级。

第二是 Fine-tune 还有很大的一个挑战,就像刚才主持人讲的没有这么多好的数据去做 Fine-tune,或者说你有数据要去 Fine-tune 的话,第一个就是可能你不愿意交给这些第三方模型公司去帮你 Fine-tune,对吧?那他们就有你的数据了;另外一个是你自己做 Fine-tune 的话会遇到一个更加大的挑战,就是你根本就无法去做你的规划。这个规划是说你既不知道你要投入多少成本,既有经济成本、人员成本还有硬件成本,你也不知道需要多大的周期。

佳芮:巨大的不确定性。

星爵:对,巨大的不确定性,就是我们说的炼丹嘛,对不对?因为现在大模型可能对我们来说还是一个相对来说不透明的一个盒子,甚至于说以后如果人工智能大模型的智能达到了 AGI 水平以后,那可能我们人类就永远无法去了解它了。因为它可能比人类的认知要高一两个维度,你永远不能去理解它为什么会这么去做的,对不对?

那么在这种情况下,如果你是要去做 Fine-tune 的话,第一个你成本不知道,第二你什么时候能做出来不知道。就像炼丹,也许三个月就能够做出来,也许三年才能做出来。

但是向量数据库的成本是固定的,成本是很明确比较低的,然后有那么多的案例能够告诉你,你大概在未来的一个星期里面能拿到什么样的一个结果,这是有巨大的一个确定性的。

更多来说的话可能不简单是一个成本高或低的问题,关键是整体的一个商业的确定性,这件事情从成本、从资源、从时间方面都能够更可控。

佳芮:我观察到一个现象,不知道 Charles 你这边看到的是什么样的。我们看到其实 Fine-tune 的场景是小模型更适合,大模型可能就不太适合。小模型 Fine-tune 之后效果会比原来好,大模型 Fine-tune 的时候一方面像你刚刚讲的不确定性,另一方面最后同样的数据可能还不如原来调好 prompt 整个的效果更好。

星爵:是啊,所以这就是为什么说 Foundation model 的研发周期很长,为什么说大家追赶了这么久也很难追赶上 OpenAI。因为大模型的参数多,举个例子就像是你按下了这个瓢,那个瓢又浮起来了,对不对?然后你在这个场景好像效果挺好了,另外那个场景又变成一个 bad case 了。而小模型来说的话,它的参数规模比较小,更加容易收敛,那肯定是更加简单的。

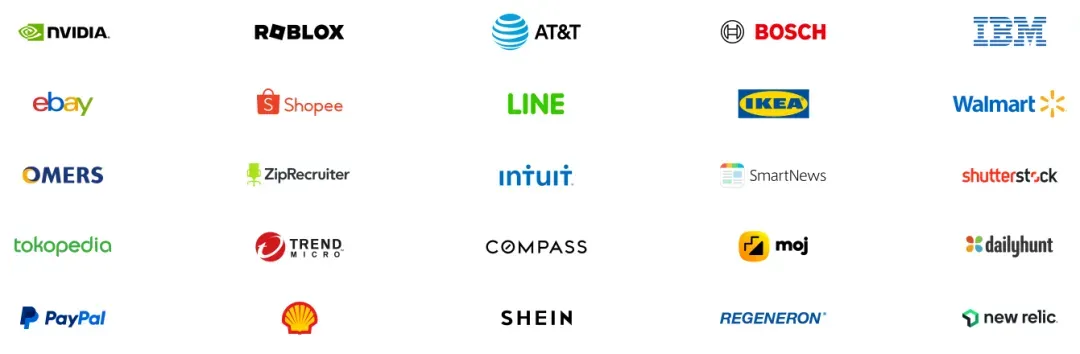

Jay:接下来我们聊聊 Zilliz 的产品 Milvus。Milvus 是全球第一款开源向量数据库,2019年开源,2020年加入 Linux 旗下基金会并成功毕业。自推出以来,Milvus 在 AI 开发者社区中广受欢迎并被广泛采用。在 GitHub 上 Milvus 拥有超过26000个 stars 和230多位 contributors,全球下载和安装量超2500万次,是目前全球使用最广泛的向量数据库之一。同时 Milvus 已经被超过5000家企业级用户所采用,广泛服务于 AI、电商、媒体、金融、电信和医疗等多个行业企业。

Milvus Github 地址:https://github.com/milvus-io/milvus

10.webp

10.webp

正如我一开始提到的,在今年的英伟达 GTC 大会上,你们发布了和英伟达合作的 Milvus 2.4版本,首次集成英伟达最新的 GPU 加速框架,在向量索引和搜索操作等方面实现了性能水平50倍的提升。

50倍性能提升,就是自行车和飞机的区别。能否请星爵给大家介绍一下,展开讲讲:

Q5:Milvus 2.4版本实现了哪些技术创新,如何做到较以往50倍性能提升?

星爵:我们先讲讲这个性能的提升。刚才讲过在性能提升方面,主要是来自于新的英伟达的 GPU 加速硬件的能力。我们知道英伟达的 GPU 有高效数据并行处理的能力,我们跟英伟达合作,把英伟达针对于向量处理发的一个新的算法叫做 CAGRA( CUDA-Accelerated Graph Index for Vector Retrieval )。

我们把 CAGRA 整合到我们的向量数据库里面,通过 GPU 的加速,通过 GPU 的数据并行处理的能力,能够使向量数据库达到以往几十倍甚至上百倍的性能提升。

这个性能提升具体来说的话,第一会在向量索引的构建这个阶段能够做到很大的一个加速。我们知道现在向量索引的构建是需要花很长时间的,通过 GPU 加速能够把向量构建的时间从几分钟降低到一分钟以内,也就是可以有数十倍的一个提升。

同时在搜索的时候,我们也可以提供一个加速。如果说你有大量的向量,同时也是一个很高维的向量,那么通过 GPU 加速搜索的效率会有很高的一个提升。尤其是搜索的吞吐率,当你要做一个并行搜索的查询,在一个 QPS 很高的情况下,这个加速的效果会越发明显。这是我们看到的性能的提升。

关于性能提升,我们最主要的目的就是希望能够帮用户降低向量数据库的使用成本。由于性能能够有50倍甚至上百倍的提升,那么意味着用户在一个大的数据量的情况下能够得到巨大的降本增效。我们跟英伟达也测试了这个性价比,我们发现在一些高吞吐率的场景里面,基于 GPU 加速的 Milvus 的方案,能够实现几十倍甚至上百倍的性价比的提升。

我们希望在未来的五年,能够把向量数据库应用的成本降低1000倍。这个底气其实来自于我们看到在未来的五年里面,在硬件的架构、计算的能力方面都会有很大的提升。作为一个软件系统,如果我们能够很好地把硬件的能力,把硬件的创新用起来的话,我们就能实现更好的性能,更低的成本。

在过去的八年里面,我们看到英伟达 GPU 的性能跟性价比提升了1000倍。那么我们也相信在未来的5-10年以内,不管是英特尔的 CPU,还是英伟达的 GPU,还是各种新兴的加速器,他们查询的性能、处理的性能,还有处理的性价比都能达到上百倍甚至上千倍的提升跟改进,这是我们看到这个产业的一个方向。

除此以外,Milvus 2.4也支持了稀疏向量的检索,所以我们现在可以同时让关键词的精确查询跟向量的模糊查询在一个向量引擎里面得到很好的支持。而且我们也支持了多向量检索,还有 Grouping 的搜索等功能。

11.webp

11.webp

但是其实我们认为如果从未来往今天看向量数据库的话,它的发展的速度,它的功能的演进速度可能都会超乎于我们今天每个人的预期,其实我们到今天都是在向量数据库的一个非常早期的懵懂的状态。

因为虽然说我是一个很优秀的数据工程师,我做这件事很久了,而且我们公司也有很多优秀的工程师,但是我们在这个行业做得越久,我们心里面就越清楚,这个行业的发展,功能的发展,产品的发展其实不是我们自己预见的。

我经常被问到比如去预见一下未来5年向量数据库会有什么新功能,发展到什么样子。其实坦诚来讲我们就不知道,我们也不应该知道。因为其实是随着 AI 的发展,随着非结构化数据的发展,随着场景的发展,应该是你的客户、你的用户告诉你他们想要什么,你坚持以用户需求为中心,开发者要什么你就做什么。然后有很多需求的功能,可能那个应用场景没有出来,那个应用场景的规模没有发生到那个阶段,你可能都是无法去预计,也无法去设计的。

所以在未来的几年,我们可能就是坚持跟开发者、跟社区在一起共同去成长。今年下半年我们预计会发布 Milvus 3.0,在整体的架构上面我们会做更多的优化,包括从功能方面我们也会做更多的优化。

更重要的就是在 Milvus 3.0我们希望能够把向量数据库整体的使用成本,包括它的部署成本、需要的资源消耗,还有整个的易用性,所有综合在一起影响用户整个的 TCO(Total Cost of Ownership ,即总拥有成本,包括产品采购到后期使用、维护的全部成本),能够帮用户降低一个数量级,这是我们希望能够去做的一件事情。

Jay:刚才您讲到我们无法预见未来,我正好最近在看《为什么伟大不能被计划》,就是 OpenAI 的两个早期工程师写的,其实里面也讲到类似的观点。包括《从优秀到卓越》其实也在讲「卓越最大的敌人其实是优秀」,就是真正伟大的事情,其实并不是被预见到的,但是中间每一步都是成功路上的垫脚石。

然后因为 Milvus 是开源的,我们就顺着聊一聊开源。

我看到之前你对外表达过你对开源的观点是:「如果你做一款基础软件,同时还不选择开源,那么你已经输在起跑线上了。软件正在吞噬世界,而开源则正在吞噬软件。」

另外你们公司的一个核心文化就是坚持开源开放,你认为这也是符合程序员精神本质的—— Talk is cheap,show me the code.

关于开源,我关注到知名创投播客《No Priors》最近对另一家向量数据库公司—— Pinecone 的创始人 Edo Liberty 的访谈。

12.webp

12.webp

访谈地址:https://www.youtube.com/watch?v=6R7YCX4Q91Q

在被主播 Sarah 问到为什么 Pinecone 选择闭源时,Edo 说:

当我们开始创办 Pinecone 的时候,我们问了一个很基本的问题:为什么人们需要开源平台?没错,其中一个原因是为了赢得信任,另一个是为了获得社区的贡献,还有一个原因是为获得用户提供渠道。我们想,只要我们做得出色,提供令人惊叹的服务,就能赢得信任,我们不需要外部贡献。

事实上,如果你看一下统计数据,即使是开源公司,99%的贡献实际上来自于公司本身,不一定是 99%,但肯定超过95%。因此,这实际上并没有什么大的区别。

然后另一位主播 Elad 补充道,他与 Databricks 的 CEO Ali Ghodsi 交流过这个问题,Ali 的观点是:

如果你可以不做开源,你就应该避免,这是一个循序渐进的挑战。因为通过开源,你可以获得分发渠道,但随后你必须找出商业模式。让一个开源项目成功就像在高尔夫球中的一杆进洞,你拿起一根棒球棒,你必须打一场全垒打,因为接下来你必须做第二次行动,确保这个东西真正作为一个公司运作。

然后 Edo 说这也正是他们在经历的。你之前说过,你们是立足于开源,开源会成为很重要的获客渠道,你们会利用开源去进行用户转化。开源是个很有意思的话题,能否请你展开分享一下:

Q6:为什么一开始就选择开源?如何看待开源的价值?

星爵:你提到的采访里面提到了 Databricks 的 CEO Ali,其实 Ali 观点的下半句在这里没有被体现出来。 其实阿里的观点是:是的,你可以不开源,你应该避免。为什么应该避免呢?因为开源是更难的一件事情,但是开源的结果就是你可以有更高的一个天花板。

佳芮:做难而正确的事。

星爵:对,其实如果我们去看过去的十年,在云的时代里面数据库的两个巨头 Databricks 跟 Snowflake 的竞争就可以看得很清楚。在最近的一轮融资里面,Databricks 在一级市场投后的估值达到了惊人的400多亿美金,基本上跟 Snowflake 在二级市场市值相差无几了。而这些一级市场投资人,他们期待明年或者今年,如果 Databricks 上市的话,他们至少还有两到三倍的一个 margin。

那么意味着美国的资本市场认为 Databricks 以后的估值会比 Snowflake 更高。为什么更高呢?我觉得有一点就是获得社区的支持跟程序员的支持。因为我们知道其实所有的软件,更加包括基础软件,其实你要赢得的是 Developer。 那么怎么去赢得 Developer?Developer 是特别不喜欢要一个黑盒子的东西的。你说你做得好,那你最好是给我看一看,我想看更多的细节。那么如果你把代码开源,就可以看到更多的细节。第一能够帮助他们成长,第二他们也能了解里面更多的运作机制。然后他们对你系统会更加有信心,也会更加信任。

13.webp

13.webp

在过去十多年的竞争里面,商业化也是 Snowflake 走到前面,营收也是走在 Databricks 的前面。Snowflake 一度的营收可能比 Databrics 多十倍以上。所以这就是 Ali 所讲的,如果你可以不开源,你就应该避免。如果你只是想做一个成功的商业化公司然后退出的话,你就应该避免,因为你早期的营收肯定是赶不上一个闭源公司的,因为你要做社区。

这也是 Ali 想讲的,就是你前半场全部在做什么?全部在做开源对不对?直到你到了一定程度以后,你要采取第二次行动,开始去做商业化。而对于闭源公司来讲,他可能就只有一场比赛,而你要打两场比赛。所以如果你只是想做一个还比较好的一个东西的话,尽早地商业化,尽早地退出,那我觉得是不需要做开源的。

但是如果说你愿意打两场比赛,你愿意做开源,做一个更加难的事情,那么后面也是有回报的。对于他们来讲,回报就是我们未来几年也许能够看到 Databricks 比 Snowflake 获得更大的成功。

佳芮:因为我也一直在做开源,就是 Wechaty。从我的视角来讲,开源可能是需要用爱发电的,可能是作为founder,你自己要对它非常有爱。但是像你刚刚讲的它很复杂,当你把大量的精力放在商业化场景的时候,其实你那个爱会被削减,你需要腾出更多的精力去把商业化做好。

然后去年底 Zilliz 举办了自己版本的 Advent of Code 活动。Advent of Code 是知名开源贡献者,同时也是一家上市公司(ACV)的首席架构师 Eric Wastl 在2015年发起的一项著名开发者社区活动,每年12月1-24号举行。活动会为参与者提供一系列编程难题,通常会涉及算法、数学、逻辑和编程技巧等,最终会评选出获胜者并得到奖励,这个活动的目的是以一种有趣和富有挑战性的方式庆祝圣诞节前的24天。

Advent of Code:https://adventofcode.com/

当时 Zilliz 邀请了25个开源项目一起共创,合作方会在活动中的某一天得到项目展示的机会,以及其他渠道的各种曝光和影响力,是一个很有意思也很有价值的活动。熟悉我的朋友知道,我是全球最大的对话式交互 RPA SDK 开源框架 Wechaty 的联合作者,Wechaty 的 Star 总数也过2万了,很荣幸能被 Zilliz 选中并邀请成为合作方。

当时大概是11月中下旬联系到的我,然后我这边需要提交一些材料。但是非常遗憾,因为我确实那段时间很忙,就 miss 掉了邮件,所以很遗憾上次没有参与你们的 Advent of Code,你们今年还会举办吗?

星爵:今年我们应该会组织一个更大规模的,欢迎你来参加。

佳芮:这次我一定要提前准备,不 miss 邮件。

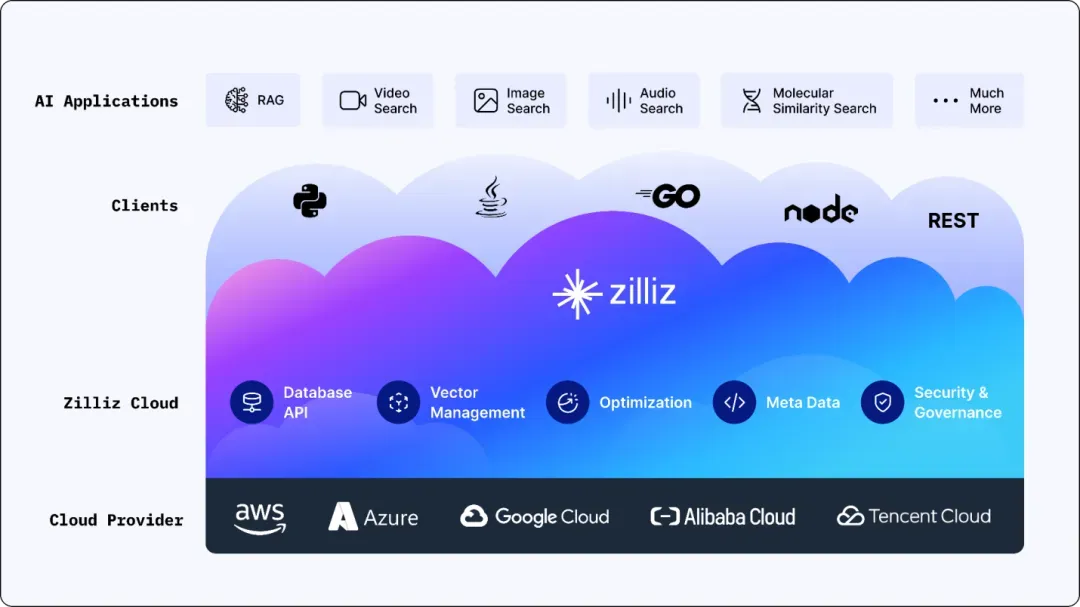

Jay:好啊,我们顺着商业化话题,聊聊 Zilliz 的另一个飞轮——云原生的商业化产品 Zilliz Cloud(https://zilliz.com/cloud)。

根据公开资料:Zilliz Cloud 是用于全托管 Milvus 的云服务产品,基于公有云为企业提供全托管的 SaaS 及 BYOC (Bring Your Own Cloud) 向量数据库服务,具备深度优化、开箱即用的 Milvus 体验。

14.webp

14.webp

Zilliz Cloud 从 Day1 起就着眼全球市场,2022年8月上线内测版,2023年3月正式登陆北美市场,同时支持 AWS、GCP(Google Cloud Platform),2023年7月登录阿里云全面开启国内向量数据库云服务,2023年12月登陆 Azure。

截至目前,Zilliz Cloud 已经实现包括阿里云、腾讯云、AWS、GCP 和 Azure 在内的全球5大云13个节点的全覆盖,也就是说 Zilliz 已经成为全球首家同时提供海内外多云服务的向量数据库企业。

15.webp

15.webp

商业模式上,Zilliz Cloud 主要提供三个不同系列的产品,第一个是面向个人开发者和小团队,第二个是公有云上代理,面向中小型企业,第三种是对数据的安全性要求更高的大企业提供专有云方案。针对你们面对的三种客户,结合 ToB 行业的特点,请星爵分享一下:

Q7:Zilliz Cloud 作为云服务产品,面对不同类型客户如何平衡易用性和企业级需求?

星爵:我其实对这个问题有不同的看法,我觉得这个问题本身可能是个伪问题。因为其实易用性跟企业级需求本身是不矛盾的,并不是说有更多的企业级需求需要满足,就一定意味着产品会越来越不易用。

举个例子,我们看到其实 Snowflake 的产品做得是相当好的,虽然他们有那么多的企业级需求,比如在数据合规、安全备份、可扩展性等方面,但是 Snowflake 始终还能够保持开盒即用。如果你要做第一个使用的 POC(Proof of Concept,概念验证) 的话,估计花个几分钟时间就可以做起来,所以说它产品做得是相当易用的。也就是说作为一个云数据库软件的行业标杆,也可以兼顾企业级需求和易用性。

另外 Snowflake 有大量的金融、电信,甚至政府客户,他们的企业级需求是相当复杂的,但 Snowflake 都能满足得很好,但是又把这些企业级需求隐藏在他的产品设计之后,让你很方便地就能够把产品用起来。

所以我觉得本质上易用性和更多的功能、更多的需求是不矛盾的,但是可能对一个公司的产品团队、工程师团队提出了更高的要求。所以我们在做一个新的产品功能出来的时候,需要尽量用更多的耐心,用更多的时间,去看如何把产品的用户体验做到极致,去隐藏后面很复杂的用户需求,这也是我们未来可能要不断去加大投入的。

而这些其实我觉得每个人都能做到,每家企业都能做到,就是需要你有耐心,需要你投入资源跟时间。一定要在你的用户体验和产品团队上面放资源,一是要不断地用程序去监控你的用户体验,发现用户体验的瓶颈,然后去改进;二是用类似用户访谈等传统的方法,去倾听用户的心声。

其实我们看到很多海外的产品最终来讲的话,如果要让一个产品能够长期地获取用户的心智,那第一点是开发者对你的信任,第二点就是开发者的体验,而开发者的体验跟你产品的易用性是直接相关的。

Jay:因为咱们也聊到 Zilliz Cloud,正好也可以简单介绍一下,包括它跟 Milvus 的区别,包括怎么去进行商业化和开源之间的一个平衡。

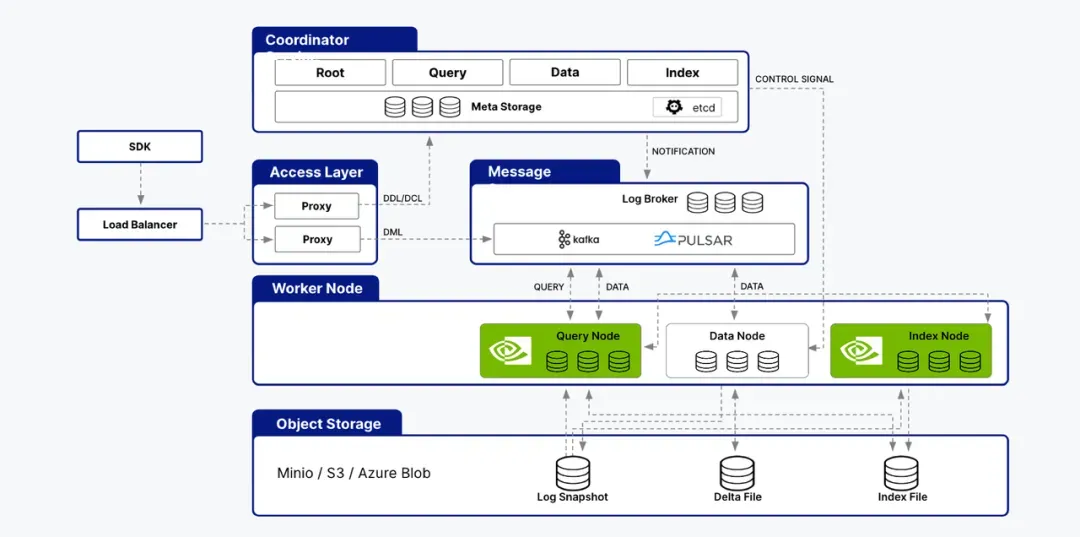

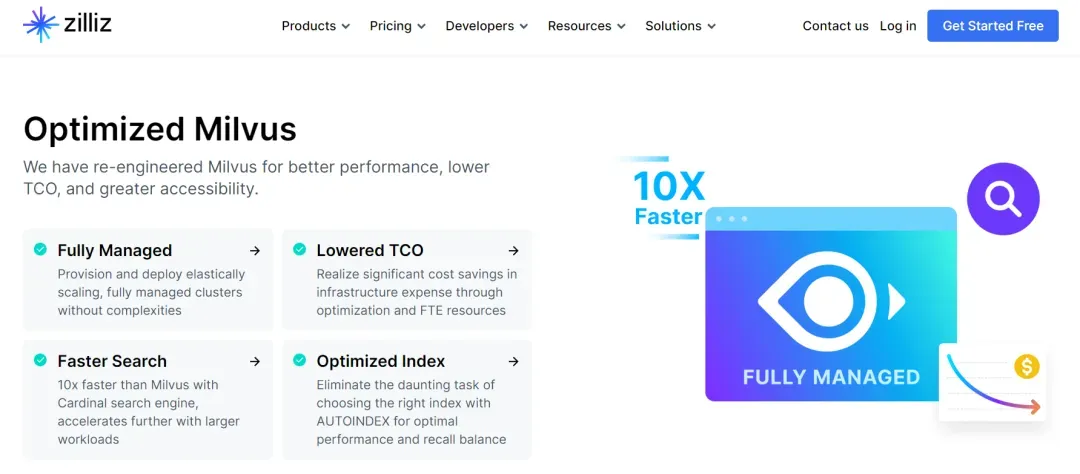

星爵:Zilliz Cloud 简单来说就是基于 Milvus 在云上面做的向量数据库的全托管服务,它的理念是基于 Milvus,强于 Milvus。

16.webp

16.webp

基于 Milvus 具体展开来讲的话,就是说它所有的 SDK、API、用户体验基本上跟开源的 Milvus 是保持一致的。所以对于用户来说,如果他以前是一个开源的用户,现在要迁移到我们的云服务上面的话是相当顺利、相当简单的,代码基本上不用做任何改变,就可以直接在上面跑起来。

那么强于 Milvus 就是说我们在功能和性能,尤其在企业级的功能和性能方面做了大量的增强,包括整个的运维、数据安全、合规、访问控制、数据的同步、跨数据中心的同步等,包括万一有数据节点失效的话,如何迅速地做数据的故障恢复、数据的备份等等,做了大量满足企业级要求的工程。这样就能保证在云上面,我们能够给用户提供一个真正具有高可用性的数据库服务,我们的高可用性事实上可以达到99.9%,对。

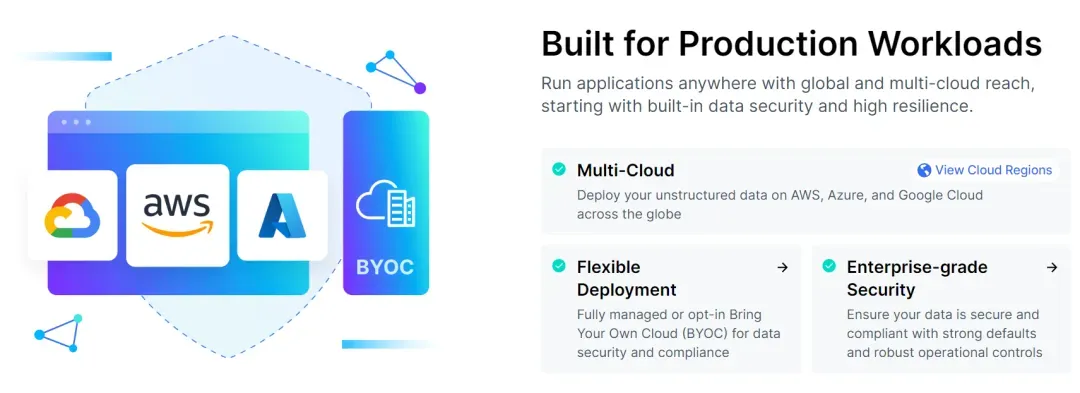

Jay:我们顺着云服务聊聊商业模式。随着大模型的进一步发展,如今越来越多的公司意识到:在 AI 价值链上可以分走大蛋糕的,除了卖显卡的,还有一个重要的角色就是云服务商。包括随着端侧或者说边缘 AI 大模型的发展,从各行各业垂直模型到人手一个大模型,云服务将扮演越来越重要的角色。这也是为什么大家看到云服务厂商纷纷大额投资大模型公司的原因之一,因为需要绑定这些公司,才能在未来互利共赢,占据更多的市场份额。

你在一次公开访谈中说:「早在前几年,Zilliz 就已经确定好了唯一的商业模式,就是在云上构建向量数据库的云服务」。你们已经看到云是未来,尤其对于非结构化数据的处理而言,未来只能是云。因为对于一家公司而言,自行维护 AI 包括非结构化数据处理、向量数据库的基础架构是相当困难的。在下一个 AI 时代里,对这种基础软件的用户来说,他们上云的需求可能不是「想与不想」的问题,而是「不得不」的问题,因为相关的模型训练、AI 部署、向量数据库的数据管理,大部分已经在云上了。所以你们坚定地把云作为公司的整体战略,也把整个商业化产品形态,全力投入在向量数据库的云服务之上。

我记得 Netscape 网景前 CEO 吉姆·巴克斯代尔曾有句名言:只有两种方法可以在商业中赚钱:捆绑和拆分( Bundling and Unbundling)。这句话非常有道理,就像 Oracle 与 Sun,微软与英特尔等,都创造了商业历史上 Bundling 的佳话,但另一方面这些公司的收入结构也都不是单一的。所以想请教星爵的是:

Q8:为什么和云服务 bundling 是 Zilliz 唯一的商业模式?向量数据库能否向上/向下延伸?

星爵:向上/向下延伸具体是指什么意思呢?

Jay:因为现在向量数据库的角色可能还是基于云构建数据库相关的服务,那向下是更去往底层走,而向上是更往用户端去走。

星爵:明白,我们选择云作为我们最核心的商业模式,就是我们认为云是以后全球的计算资源,包括算力和数据的一个高效组合的很重要的方式。所以尤其是对于我们自己公司来说,云是我们能够找到一个快速增长、快速复制、快速达到规模性增长的一个很重要的方式,甚至是唯一方式。

我们看到有很多公司,他们可能有线下部署,有其他的一些专业服务等等,这里会遇到的一个很大的问题是:到了一定的规模以后,公司就很难增长了。因为如果要增长就需要投入更多的资源,然后公司的投入产出比和边际效益都会越来越会恶化。甚至这些公司会发现,他们的成本和产出会永远达不到一个平衡点。

其实这是很多公司遇到的问题,虽然有产品,但是如果在产品的部署方式、分发方式方面,如果模式选得不对的话,就会让你从一个产品型公司变成一个项目型公司,变成一个实施型公司。

而云服务是让一个产品型公司,不只是在研发端做出一个产品,而是在分发、在部署、在以后运维、在以后升级的时候,都能够通过产品的方式去完成整个的商业闭环。对于 Zilliz 来说,我们坚定地想做一个产品驱动型的公司,我们也希望建立一个以产品为核心的商业模式,所以云产品形态会是我们未来长期去坚持的商业模式。

17.webp

17.webp

然后说向量数据库怎么样去上下延伸。其实这个问题特别好,虽然大部分人都会把 Zilliz 理解为一个向量数据库公司,但其实我们自己想做的不只是一个向量数据库,向量数据库可能只是我们的一个起点。

其实在我们的生态里面,我们既有像 Towhee 这种项目可以去做非结构化数据的 ETL(Extract-Transform-Load),也就是做从非结构化数据到向量数据的提取和转换;我们也有像 Attu 这样的开源项目可以去提高非结构化数据的可观测性;我们也有像 GPTCache 这种项目可以基于向量数据库去做语义的缓存,而语义的缓存在 AI 时代很可能会取代像 Redis 这样的基于关键词匹配的缓存;等等。

Towhee:https://github.com/towhee-io/towhee

Attu:https://zilliz.com/attu

GPTCache:https://zilliz.com/what-is-gptcache

所以我们是希望能够建立一个产品矩阵,这个矩阵是以向量数据库为底座的,上面既有数据的清洗,数据的转换,也有可观测性监控,也有像 GPTCache 这种语义的缓存等等。最终来讲,我们希望的是面向于非结构化数据搭建一个端到端的数据处理平台,所有跟非结构化数据相关的处理,不管是从数据的预处理到数据的查询,再到整个数据的生态,我们希望有一个完整的产品矩阵去提供一个完整的生态链。

而在这个生态链里面,我们又希望跟上游的像大模型厂商、应用框架厂商,下游的像硬件厂商、云厂商能够做大量的整合。最后能够为我们的 AI 开发者,为我们的非结构化数据处理的应用构建者,去提供一个完完整整的非结构化数据分析和处理的平台。

Jay:我们接下来聊聊竞争。随着向量数据库的火热和预期内广阔的市场空间,越来越多的玩家也在涌入这个赛道。除了专门做向量数据库的创业公司以外,还有比如前几轮的传统数据库厂商、互联网大厂,甚至某些大模型公司都在入局。

面对传统数据库厂商的挤压,我看到你之前的一个类比很有意思,就是:电动车和燃油车。你观察到「虽然燃油汽车厂商能制造出电动车,但没有任何一家燃油车厂商真正能够做出特别好的电动车,他们很难彻底转向新能源汽车平台。这些厂商可能会在混合动力车型上有所进展,但再进一步完全转向新能源平台对他们来说是相当痛苦的,这个鸿沟也许永远跨不过来。」

面对其他的竞争对手,你用专业选手和业余选手的比喻:「如果用户的向量数据量不大,对延时吞吐率的要求也不高,那非专业选手可能也可以胜任;而如果数据量比较大且需要很高的吞吐率,那么必须且只有专业的向量数据库产品才能提供这么好的性能,处理这么大的数据规模。」

另外你们也有自己的基因和 trade-off:「从诞生第一天起,Milvus 和 Zilliz Cloud 就关注于服务企业级用户,面向生产环境,也是全球第一个能够支持百亿规模向量的向量数据库。」

但另一方面,你也多次说到:「AI Infra 是一个赢者通吃的市场」。因为确实向量数据库的玩家还在越来越多,甚至有的玩家在某方面也跑出了可能不逊色于 Zilliz 的成绩,所以想请星爵站在今天这个时间点再分享一下:

Q9:面对愈发激烈的向量数据库市场竞争,Zilliz 将如何保持领先、构建壁垒?

星爵:这件事情在我们看来是很简单的。第一是对外,以开发者为中心,倾听用户的声音。倾听开发者的声音就是专注于开发者,专注于你的用户,不要专注于你的竞品,就专注于你的用户需求,然后根据需求去快速地迭代你的产品。

第二是对内,苦练你的内功。拿到这些需求以后,尽快去迭代你的产品,并且持续地比别人更快地去迭代你的产品。那就意味着你会有更好的性能、更低的成本、更多的功能,意味着更多的企业级需求你能够迅速地去满足。

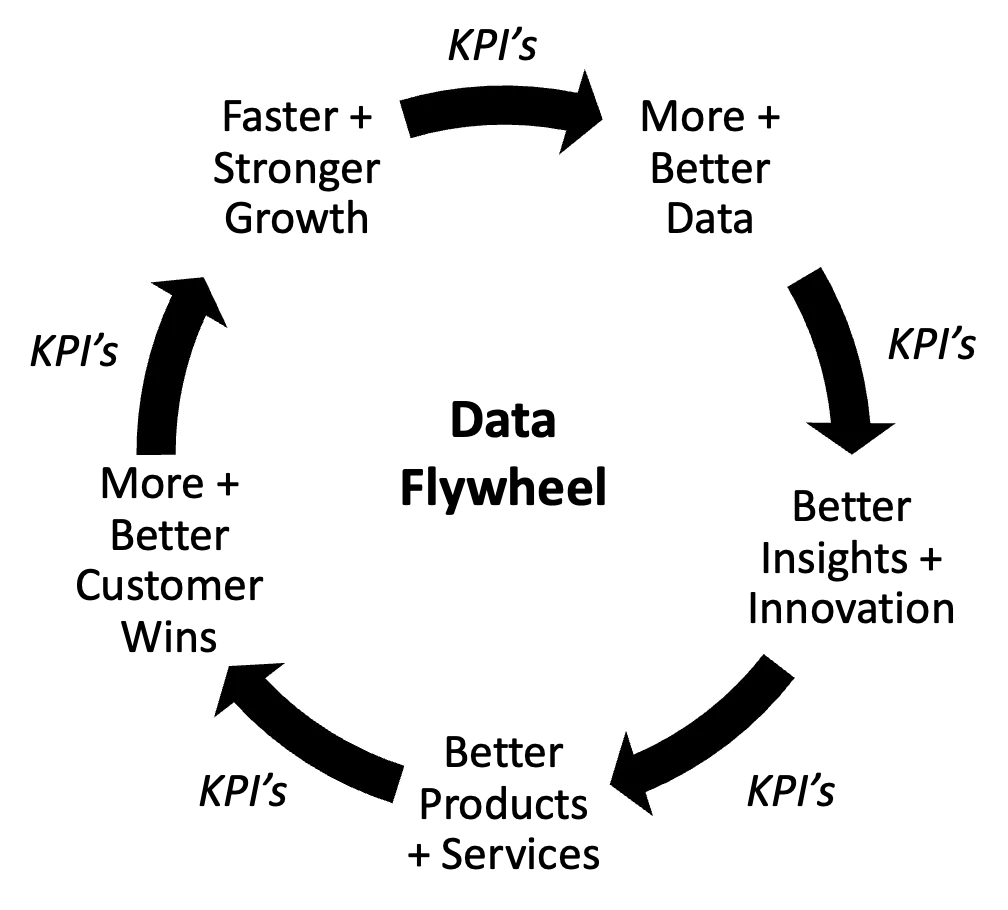

其实不管是对内能力的修炼,还是对外满足开发者的需求,其实都是滚滚向前的轮子,它并不是静止的,而是不断往前面去滚动的。最重要的就是我们如何能够构建一个飞轮,然后让这个飞轮有更高的动能。

18.webp

18.webp

对于我们来说,我们的策略就是我们既有开源,又有云原生的商业化产品。那意味着我们在倾听用户声音的时候就有两个渠道,我们既可以通过开源社区大量地获得用户需求,我们也可以通过商业化产品拿到大量商业化客户的需求,所以我们在需求端能够快速地去迭代。

同时我们的开源产品从第一天开始就和云产品是兼容的,我们采用了一个云原生的架构,那么我们的开源产品跟我们的云原生产品的 API 架构和用户体验基本上是保持一致的,他们大部分的核心组件也是一致的。那就意味着我们可以在拿到开源和商业化的需求以后,能够以更快的速度去迭代我们开源的产品,同时去迭代我们商业化的产品。

最终来说,我觉得每个企业要保持优势,核心是如何保证你更好的运营效率。这里面包括两个效率,第一就是你信息获取的效率,你要去听社区的心声,达到开发者的需求。第二就是你内部的执行效率。

我们也希望通过开源、云原生这两个飞轮,让他们能够一起旋转,能够让我们接触到更多的复杂场景,能够拿到更多的用户需求,能够让我们这两个产品的共同迭代产生一个耦合的效益。然后最终让我们的产品能够给用户提供更好的使用体验,能够更好地服务我们的开发者。

Jay:下一个话题是全球化。前面我们提到,Milvus 已经被超过5000家企业级用户所采用,广泛服务于 AI、电商、媒体、金融、电信和医疗等多个行业企业。而 Zilliz Cloud 也已经实现全球5大云13个节点的全覆盖,成为全球首家同时提供海内外多云服务的向量数据库企业。

事实上,Zilliz 也是中国出海全球化的优秀科技企业代表。从 Oracle 的背景,到开源,再到中美双 office,我想 Zilliz 能成为少有的在 AI 时代细分行业中占据领先地位的华人背景公司,和你及你的团队拥有全球化视野也是分不开的。

「软件正在吞噬世界」,软件也理应生而全球。作为一档关注出海全球化的播客,我们从狭窄的认知里也能很强烈地感受到,尤其是 AI 时代的创业者们,几乎每个人都对出海全球化有不同程度的兴趣甚至野心。想请星爵给大家分享一下:

Q10:Zilliz 在全球化发展方面有什么经验和策略?AI 时代中国创业者如何走向世界?

星爵:我们在走向全球化的过程中,其实还在积极地摸索,所以可能也说不上太多的经验和策略,大家都在摸着石头过河,可能就分享几个小的我们学到的经验教训。

第一就是我觉得所有的团队,包括领导团队,包括公司的每个员工,如果一定要做全球化的话,一定要有一个特别清醒的认知就是:从零到一的痛苦过程一定会重新来一次,你想不想承受这个痛苦?

我们看到在过去几年,不管是中国的企业往海外走,还是海外的企业来中国,其实成功的企业都是同样的一个心态,就是把自己放空。怀着空杯的心态,带着十分的勇气,然后把所有的痛苦可能要重新再经历一次,不管是建团队还是说建渠道、做营收,可能都要重新做一次。这是第一个心态上面做的准备。

第二就是全球化其实是一个无数的局部化和本地化的组成。其实全球化也不是特别神奇的一件事情,拆开来看的话,比如你要进入100个市场,那你就要做100个本土化,最后就是你如果能够把这100个本土化做好的话,那你就在100个国家和地区实现了你的全球化。

19.webp

19.webp

所以全球化是由无数个小的本地化去构成的,没有特别神奇的 recipe,就是你要有很多耐心去一个一个地在每一个地区、每一个国家建本地的团队,融入本地的文化,用本地的方法去做生意。各方面都是需要你从零到一重新做一次的过程。

最后我想分享的一点是,接下来中国的创业者、中国的开发者一定会走向全球化。这可能是我的一个坚定的信念,也是基于我长期的观察。因为中国的开发者,现在其实我们的能力已经外溢了,而且我们的能力也必须得外溢。因为中国的开发者,尤其是工程师是以全球前所未有的速度在增长的,我们每年中国要增长几百万个工程师。而这几百万个工程师,以后他们的能力在国内是不能够完全被消化的。

我们中国已经有大量的工程师了,存量已经很大了,而增量还这么大。所以这几百万个工程师如果都待在国内的话,那国内市场会越来越卷的。我觉得正确的打开方式是,我们要把这部分工程师的产能着眼于全球,有太多的问题需要工程师去解决了,有太多的创新需要工程师去解决了,全世界还有很多地方是很缺工程师的。

在过去的几十年里面,我们中国可能在全世界的生产制造方面有巨大的产能输出。接下来我觉得我们中国有一个特别好的资源,就是我们中国有全世界最大的工程师资源,以后这个产能我们也是全球第一的。

我们要向全球去输出,为全球的不同国家、不同地区去提供更好的应用,去服务他们更好的生活。这是咱们中国接下的创业者、工程师可能是被自己选择,或者是被历史选择的一个使命。

佳芮:因为句子也在做出海,我也学到很多,总结三个学到的观点。第一个我觉得特别好:十分勇气,空杯心态;第二个是全球化是无数个局部化的叠加;第三个是中国接下来会从生产制造的输出到工程师的输出。

那回到向量数据库,我们聊几个相关的可能比较热门的话题。

首先是检索增强生成 RAG (Retrieval Augmented Generation)。RAG 结合检索 (Retrieval) 和生成 (Generation) 两个过程,可以提高文本生成的相关性、准确性和多样性。具体来说,RAG 通过在生成文本输出之前先检索大量相关信息,然后将这些检索到的信息作为上下文输入到模型中,从而生成更准确、更具体的回答,缓解幻觉问题。这个是前面我在聊到「犟嘴」问题时提到的技术。

RAG 一词最早来自于 Facebook AI 部门 NLP 研究员 Lewis 等人在2020年发表的一篇论文中。当时的想法是使用预先训练的语言模型 (LM) 来生成文本,但使用单独的检索系统来查找相关文档来调节语言模型。

论文地址:https://arxiv.org/abs/2005.11401

后来随着大模型的演进,人们对于生成文本的实时性、准确性以及数据安全性等提出了更高的需求,RAG 随之火热起来。从目前来看,RAG 与向量数据库之间的关系是密切且互补的,向量数据库在 RAG 技术中扮演着核心角色,比如通过向量数据库可以实现更高效的数据表示、更快速的检索、更大规模的数据处理、更好的生成质量、更好的数据隐私保护等等。通过这些必要的技术支持,RAG 能够有效地利用外源知识来增强大模型的准确性和可靠性。

关于 RAG,前段时间有一个很有热度的话题就是:随着大模型上下文窗口的变长,RAG 还是否有价值。

我看到 Zilliz 官网就有一篇博客文章,标题就是:RAG会被长上下文LLM杀死吗?文章讲到:

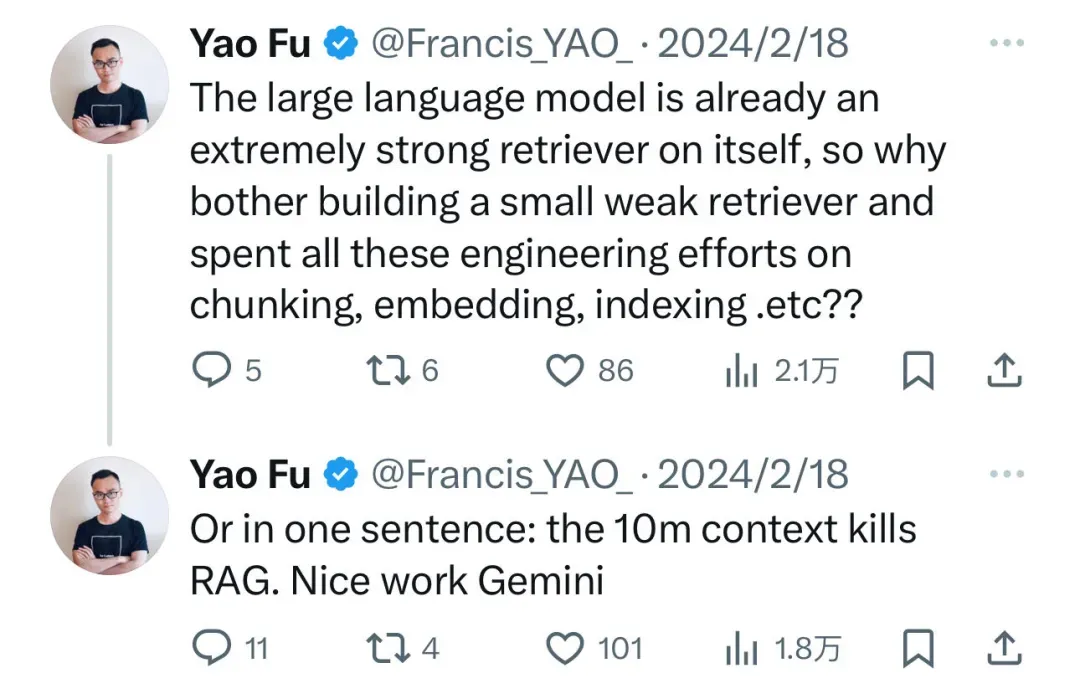

由于 Gemini 在处理长上下文方面表现出色,甚至有人高喊「RAG 已死」。比如爱丁堡大学博士符尧在评价 Gemini 1.5 Pro 的帖子中写道:「大语言模型已经是非常强大的检索器,那么为什么还要花时间构建一个弱小的检索器,并将时间花在解决分块、嵌入和索引问题上呢?换句话说:一个拥有1000万 token 上下文窗口的大模型杀死了 RAG。」

20.webp

20.webp

文章地址:

https://zilliz.com/blog/will-retrieval-augmented-generation-RAG-be-killed-by-long-context-LLMs

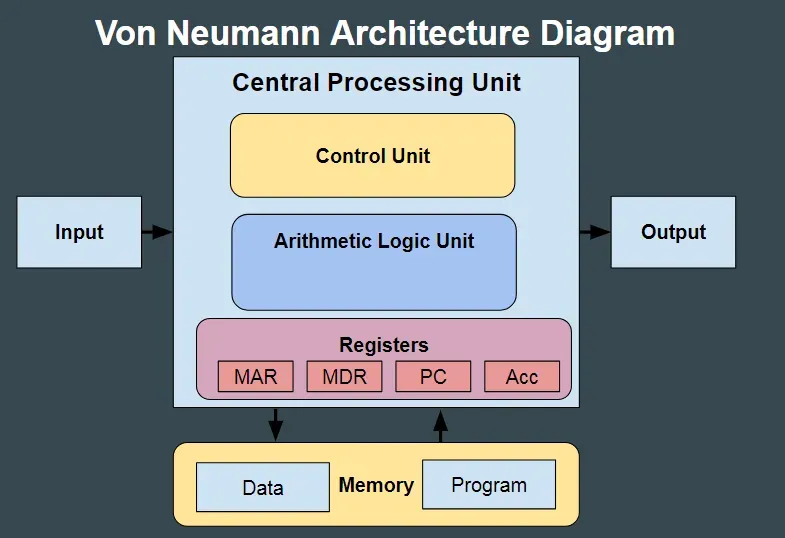

在这篇文章中,你们的观点是:大内存的发展并不意味着硬盘的淘汰,因为:

大模型技术正在改变世界,但无法改变世界的运行规律。自冯·诺依曼架构诞生之日起,存储器、计算器和外存就是分开的,即使在单机内存已经达到 TB 级别的今天,SATA 硬盘和闪存依然在不同应用场景下发挥着重要的价值。对于大模型而言,长期记忆的重要性也将持续存在。AI 应用的开发者一直在追求查询质量和成本之间的完美平衡。当大型企业将生成式人工智能投入生产时,他们需要控制成本,同时保持最佳的响应质量。RAG 技术和向量数据库依然是实现这一目标的重要工具。

前面我们提到的 A16Z 的那篇《大语言模型应用的新型架构》中也有类似表述,文中写道:

另一个悬而未决的问题是,随着大多数模型上下文窗口的增长,嵌入(embedding)和向量数据库将如何发展。人们很容易说嵌入将变得不那么相关,因为上下文数据可以直接放入提示中。然而,专家们对这个主题的反馈表现出了相反的情况——随着时间的推移,embedding pipeline(嵌入管道)可能会变得更加重要。长上下文窗口是一个强大的工具,但它们也需要大量的计算成本。因此,有效利用它们成为当务之急。我们可能会开始看到不同类型的嵌入模型变得流行,直接针对模型相关性进行训练,以及旨在利用和实现这一点的向量数据库。

其实我第一次看到「RAG 会被长上下文杀死」这种说法的时候我觉得还是带着玩笑的意思的,因为今天的向量搜索的准确性还是不够,所以才会提到只要你把所有内容都给大模型,就一定会「大力出奇迹」,效果就是最好。但是这显然只是一个非常小的领域的说法。如果拉长来看,RAG 或者经常我们说「外挂数据库」的价值是绝对不可替代的。

首先我认为上下文的长度一定会越来越长,1000万 token 也只是一个开始,后面一定还会有成千上万倍的提升。但是对于一个相关领域需要检索到的数据的需求是更多的,这已经不是用 TB 来衡量的事情了。上下文窗口是没有必要有这么长的,就像我们今天的电脑和手机,我记得我很小的时候电脑还是用软盘的时代,内存还是MB 这样的体量,我上大学的时候还会关注内存,内存越大的电脑性能越好。

但是今天,其实我们已经完全不需要关注内存了,这就意味着我们现在每天的基础操作,内存已经完全不是限制了,我的 MAC 电脑的内存也不过 24G,我们完全没必要搞上几个 T 的内存,这本质上也是「硬件过剩」,但是我们还是需要外接更多的硬盘,包括云盘,他们的定位是完全不一样的。就像你的类比,内存和硬盘,之于长上下文和 RAG。 在这里也想请星爵来给大家聊一聊:

Q11:Long-context 长上下文的发展对向量数据库有何影响?

星爵:我觉得本质上讲什么长上下文会杀死向量数据库,这就是为了抓取眼球的耸人听闻的标题。如果按照这个标题来讲的话,那飞机的发明会杀死轮船,对不对?那我们就不需要轮船了,飞机多快对不对?但事实不是这样的。

在飞机发明了100多年后的今天,其实飞机也并没有杀死轮船,反而轮船的生意越来越大了。因为第一飞机的货运成本比轮船大很多,第二就算是全世界最大的巨无霸的运输机,也不能像一艘10万吨级的游轮那样运10万吨货物。

21.webp

21.webp

所以本质上来说,这不是一个谁杀死谁的问题,每个都有不同的应用场景。

在我看来更长的上下文,其实对向量数据库反而是个利好。为什么这么说呢?因为如果有更长的上下文,意味着你可以从向量数据库里面拿到更长的文本,然后放到大模型里面。之前上下文长度比较小的时候,从向量数据库里面能找到 TOP 10、TOP 100、TOP 1000,那么 token 可能就已经超过了 10K、20K,那就限制了你放进向量数据库里面的相关内容大小,你只能限定在很小的 Top k,而不能把更多的 Top k 放进去。

举个例子来说,比如有一家历史很长的公司,每周都会开周会,如果要查有史以来所有的周会记录,我们要去看到底有什么共同的规律,或者过去十年我们开周会的主题有什么变化,公司的策略有什么变化等。那么如果你要把所有的知识都给大模型,你要完全消灭大模型的幻觉的话,其实向量数据库是可以完全把你所有的周会信息都拿到的。但是如果是十年的话,那么一年有50多周,你就有500多篇周会记录,那么拿出来的 token 是很多的。

如果在一个上下文有限的情况下,你是无法全部给到大模型的。这也是大模型之前比较大的一个限制,所以大模型的上下文我觉得是要适当地去增长的。

还有一点特别有意思,就全球范围来看,卷上下文 token 数这件事其实在美国的一些领先的公司,比如说 OpenAI,他们并不是在拼命地卷上下文的 token 大小的。

佳芮:国内卷是吧?

星爵:对,在我的观点来看,说白了就是大家打不过 OpenAI,就要找点这种差异化去做。这个事情我们之前也见过,就是手机的产品设计比不过 iPhone,那就比内存大小嘛,但是内存那么大真的有必要嘛?大家还是觉得买 iPhone 好,对不对?比如说你家的手机内存比 iPhone 大五倍,那用户真的用得着吗?硬盘大十倍,我也装不满对不对? 我觉得其实现在市场慢慢地也趋于冷静了,长上下文对于一些在追赶 OpenAI 的大模型公司来说,可能是一个市场营销方面很好的卖点。就好像我们中国以前的手机厂商要去跟苹果竞争,可能在品牌在综合能力比不上的情况下,那我们就卷硬件参数,比如硬盘比苹果大。类比下来,在大模型的综合效果达不到 OpenAI 的情况下,那就卷自己的上下文比你大,对不对?

但是后来大家就会发现,卷上下文长度到后面来说,其实给用户的体验并没有太多提升。并且说句实在话,没有几个用户敢用1000万 token 的上下文,因为每一个 token 都是要收费的。如果用户天天每一条 query 都要用1000万个 token 上下文的话,我估计这个用户的账单会是个天文数字。

所以我们就很理性地去看待这个问题,不是谁杀死了谁,这其实是一个行业共同发展的状态。然后在不同的应用场景,在不同的成本考量的情况下,其实所有的方案都有自己适当的应用场景。

另外我觉得每一个开发者都应该有自己独立的判断能力,要不然可能今天会听到高铁杀死飞机,明天飞机要把轮船给杀死了,后天火箭又要把飞机给杀死了,对不对?其实大家的应用场景不一样,解决的问题可能也不太一样。

Jay:对,刚才提到你们官网的那篇文章提到了冯·诺依曼架构,这个话题其实一直有很多人讨论,我们也简单聊聊,算是畅想一下吧。

先回顾一下冯·诺依曼架构(Von Neumann architecture),这是一种计算机系统架构,是现代计算机设计的基础,至今仍对计算机硬件设计产生深远影响。这个架构以20世纪中叶的数学家和物理学家冯·诺依曼命名,他在1945年提出了这个概念。简单来说,冯·诺依曼架构讲的是把计算机的输入、存储、处理、计算、输出、控制都分离开,互相分工。 与之对应的争议点也被叫作「冯·诺依曼瓶颈」,指处理器和内存之间的数据传输速度限制了计算机的性能。

22.webp

22.webp

我简单做了些功课:人脑大约有860亿个神经元,功率是15-20瓦;而同等规模的比如800亿参数的大模型功耗却可以达到上千瓦。

今年英伟达 GTC 大会上黄仁勋在介绍最新的 GPU Blackwell 时也表示:「此前,训练一个 1.8 万亿参数的模型(一般被认为是GPT-4 的参数量)需要 8000 个 Hopper GPU,并消耗 15 兆瓦的功率(1兆瓦=100万瓦)。而同样的工作只需要 2000 个 Blackwell GPU 就可以完成,而且功耗仅为 4 兆瓦」。4兆瓦相比人脑的功率来说也是个天文数字了。

另外在最近美国红杉资本的 AI Ascent 活动上投资人 Stephanie Zhan 和 Andrej Karpathy 有一段对话也讲到这方面。

对话地址: https://www.youtube.com/watch?v=c3b-JASoPi0&list=PLOhHNjZItNnOoPxOF3dmq30UxYqFuxXKn&index=4 Stephanie 问到当前大模型研究面临的挑战,Andrej Karpathy 提到的最后一个挑战就是冯·诺依曼架构的瓶颈。他认为:「现在是计算机架构非常令人兴奋的时候。我不是计算机架构师,但似乎我们现在的效率低了一千到一百万倍,或者是这个数量级。应该有非常令人兴奋的创新可以将其降低。」

关于这个问题,之前你对外表达过的观点是:「如果从生物学角度,人脑之所以能进化出海马体,是大脑的区域要分工,让人体更高效。放到计算机科学里,过去的几十年里,经典的冯·诺依曼架构强调存储与计算分离。存算分离的一个核心原因是,它能达到成本和效率的最佳平衡。存储的价格在历史中远低于计算的价格,计算的价格是很贵的。存储和计算分离以后,如果有些任务我们之前处理过,我们学会了那些东西,就不用再在计算单元里面重新做处理,直接从存储体里去调用就好。」

你站在生物学结合经济学的角度来理解这件事情,这很有意思。另一方面,人工智能最初的诞生其实就是那些科学家希望能在计算机上复现人脑,所以看起来我们还有巨大的差距。能不能请你展开讲讲,在你看来:

Q12:Transformer 遵循的冯·诺依曼架构未来可能颠覆吗?对向量数据库的影响是什么?

星爵:我觉得冯·诺依曼作为一个经典的抽象,它被奉为在数据库领域最核心的一个 fundamental 的原理,是有存在的原因的。其实它的架构很优美,简单来说就是存算分离。存算分离这件事情,不管是在生物学还是在社会学上,是我们都可以找到印证的一个原理。本质上是什么呢?本质上是分工能实现效率的提升。

先不看计算机,在我们人类社会里也是一样的。如果我们回到几千年前的话,人类社会是没有这么多职业分工的。要不就是有那么几个人可能什么都懂,然后学科也分得不是那么细。但是经过了几千年以后,我们的社会怎么发展呢?我们的社会就职业分工分得特别特别细。现在有几百种不同的职业,然后在每个职业、每个学科里面也有更多的细分。

比如说医生,如果在古代可能就是大夫,没有什么区分,而现在我们看到大夫有这么多的科室,然后每个科室里面又有很多专科专病,对不对?然后在某个病上面又有专门的专家。这种分工其实就代表着能够达到更好的效率和资源的配置,意味着你可以专注一件事情,而不用在乎其他事情。

对于我们人类社会,你专注一件事情可以把事情做得更好,会有更好的效率。对于计算机来说,存算分离也是这样的。本质上在电子计算机的时代,如果说你要让电子元器件同时做计算和存储,那么在功耗,在设计的密度等方面都会很快遇到瓶颈。

我们知道存算分离以后,现在不管是我们存储的芯片,还是我们计算的芯片,可能都会在某一个纳米制程里面遇到能量强(Power Wall,指在提升芯片性能时遇到的能耗和热量限制)这个问题,而使它的密度不能再提高了。如果我们不用存算分离,而把它们做到一起,那么会远比现在更早要达到这个能量强,因为它的设计会比现在更复杂。

23.webp

23.webp

所以存算分离我觉得是我们人类社会的一个最基本的原则,不仅是一个计算机设计原则。本质就是分工能达到效率的提升跟成本的降低,能达到资源更好的配置。

至于再往未来去发展,我倒是觉得可能会有些变数,比如说接下来量子计算机的发展。量子计算机现在去讲的话可能离我们比较远,但是未来的十年、五十年,可能会满足让我们人类的算力要再提升100万、1000万甚至1亿倍的需求。 在量子的世界,可能跟电子的世界不一样。在量子的世界里面,我们能不能把存储和计算放在一起,同时不去损失效率,不影响成本,这可能是一个未知的值得探索的领域。

总之我认为在未来的很长一段时间里面,冯·诺依曼架构还继续会影响我们,不管是计算机的处理器架构,还是各种数据库架构的设计和发展。甚至于说冯·诺依曼架构体现的我们社会经济学的原理,在未来的很多年里应该还会持续影响我们人类社会的发展。

Jay:下个话题我们继续畅想一下。先讲一个故事:

1953年,有个叫 Henry Molaison 的人因为饱受癫痫症带来的痛苦,接受了一个极具实验性的手术。手术切除了他的双侧内侧颞叶、杏仁核以及海马体前部的三分之二,因为这些区域在当时被认为与癫痫发作有关。术后,医护人员发现 Henry 的记忆就像沙滩上的字,时间的海水一冲就会消失,无法形成新的记忆。但他对以前发生的事情、语言中每个词语的意义、理解和发音却记得一清二楚。也就是说,海马体的缺失使他的记忆永远停留在了手术那一天。

这次手术让他成为神经科学家们最耳熟能详的病人,他也是神经科学史上最著名的失忆者。

关于向量数据库与大模型的关系,用这个例子来比喻再恰当不过:大模型是大脑,向量数据库就是海马体。记忆的缺失让每一次和大模型的交互都像不断重来的闭卷考试,而向量数据库让这个过程变成了开卷。一方面,大模型能浏览专有的数据和知识,降低幻觉,使回答更精准;另一方面,大模型能根据结合自己过往的数据了解用户的需求,实现更好的个性化。这可能是目前达成的阶段性共识。

但关于这个问题,你却有看似不同的说法。你说:「归根究底,向量数据库不是为大模型而设计的,它服务的是整个 AI 领域,拥有更大的场景和市场」。「大语言模型是向量数据库的第一个杀手级应用,但向量数据库作为一个基础支撑,未来的场景一定是横跨计算机视觉、自动驾驶、推荐系统、AI 制药等多领域、多模态的」。

你还做过一个预测:「尽管很多 AI 开发者接触到的第一个模型可能是 ChatGPT 背后的模型,未来五年,他们却会看到更多的 Foundation Model。这在计算机视觉领域已然成真,未来将遍及自动驾驶、推荐系统、生物制药等领域。届时,开发者会发现一个有趣的现象,每个 Foundation Model 都需要一个语义的存储系统来帮助自己管理诸如文本、图片、用户行为等数据」。

面对未来的市场,你的预测开启了一扇更大的门。但另一方面,门外现有的巨头们也在虎视眈眈。而且我发现这一轮技术革命起码到目前为止,除了 OpenAI 勉强算(因为颠覆的背后也离不开微软的支持),目前好像并没有发生真正的颠覆式创新,也就是从可能边缘的细分领域冒出头来的挑战者,颠覆巨头,并逐渐成为市场领导者。

当然,这一轮革命才刚刚开始。但巨头们仍然很年轻且有战斗力,虽然大公司病依然存在,但他们并没有说出「这个世界上只需要五台计算机」这样傲慢的话。他们不怕失败,快速学习、调整、跟进,同时他们还掌握着挑战者们可能梦寐以求的海量资源。

不知道面向未来,星爵怎么看,请你分享一下:

Q13:向量数据库的想象空间有多大?是否有颠覆传统数据库巨头的机会?

星爵:就「大模型是大脑,向量数据库是海马体」这个说法来讲,其实这里面最核心的一点就是:其实大家搞不清大模型是什么东西,大家把大模型跟大语言模型划了等号,这是我觉得最大的一个片面的认知误区。

大模型应该叫做 Foundation model,就是基础模型,它其实在英文里面不叫 Big model,也不叫 Large model,叫做 Foundation model。而大语言模型虽然叫 LLM,但是我们知道大语言模型其实只是 Foundation model 的一种,是在自然语言领域处理文本和文字的一种 Foundation model,而像 OpenAI 发布的 Sora 就是视频领域的一个 Foundation model。

在过去我们已经看到了 Scaling Law(尺度定律,指模型能力与模型尺度之间的渐近关系)在自然语言、视频和图片领域取得了验证和成功,我们现在也看到在推荐系统、AI 制药、风控等领域都在逐步地取得初步的成功。如果我们认为 Scaling Law 是未来还能再指导我们在下一个五年不断去提升人工智能能力的一个基本准则的话,那么模型的规模会越来越大,并且在越来越多的领域里面会出现大模型。

By the way,我们其实已经看到了在 AI 制药领域有更大的一些模型,在用更大的数据去训练,甚至用大语言模型加上一些微调,就能够做一些药物的预测等等。

大概在半年多之前我也预测,在自动驾驶领域一定会有大模型,有 Foundation model 出现的。现在 Tesla 已经走出了第一步,最近 Tesla 发布的自动驾驶模型就完完全全是用大模型去驱动的,而不是之前用无数的算法补丁的方式去驱动的。

所以如果说向量数据库是未来所有 AI 的存储体、记忆体,为所有以后的 Foundation model 去提供存储,这个观点我是赞同的,这也是我一直以来的观点。但是如果说向量数据库只是大语言模型的海马体的话,那我觉得就有点以偏概全了,并且这个说法完完全全低估了向量数据库的使用空间。

24.webp

24.webp

虽然过去的一年多在大语言模型这个领域里面,向量数据库有很大的应用场景,这个场景增长得特别快,但同时我们也看到在图片的模型、在视频的模型、在推荐系统的模型,在 AI 制药的模型、在自动驾驶的模型等方面,向量数据库的增长也相当快。

对于后半个问题,是否有颠覆传统数据库巨头的机会,其实我不太认同这个问题。我觉得为什么一定要说颠覆呢?其实很多时候不管做生意还是技术的创新,都不是一个你死我亡的零和游戏。飞机的发明就一定要颠覆大航海时代嘛?你就是多了另外一种选择而已。

其实我看到传统的数据库巨头包括 Oracle,包括 Snowflake,他们都还会有强劲的增长。像 Oracle 最近这几年每年也都能保持两位数的高速增长,这是相当不容易的。这意味着我们的 IT 化还远没有走到尽头,我们的数字化和 IT 化还有很长的路要去走。而 Oracle 这样的数据库是承载着我们数字化和 IT 化的一个排头兵,是很重要的一个基础设施。我估计我们全球的 IT 化现在连10%都不到。

佳芮:中国的很多公司还没有完成数字化的转型。

星爵:对,数字化和 IT 化,我们全球范围是低于10%的。那这么看的话,如果要到80%的渗透率,我们至少还有八倍的增长空间。我们花了50年渗透到了10%,后面其实还有很长的路要去走,让这个规模能扩大八倍。然后说到我们的智能化、 AI 化,现在可能连1/1000都不到,可能是1/10000,现在还是很早期的一个阶段。

所以我认为在未来传统的数据库,包括结构化数据库他们还会持续增长,他们还有很大的市场增长空间,他们每年保持20%甚至更高的一个增速是完全有可能的。同时向量数据库、非结构化数据处理,第一这是个空白的市场,第二市场的容量又很大,所以可能会有更高的一个增速。

但是有更高的增速并不意味着你要颠覆。还拿海运和航运举例,航运的增速可能在过去的100年里面没有航运的增速快,但是并不意味着航运一定要颠覆海运。海运其实由于全球贸易,由于过去几十年的全球化,海运每年的增长还是很高的,虽然不像航运增速这么快。

所以我觉得结构化数据处理和非结构化数据处理未来是一定是会并存的,它们解决的是两个不同的问题,它们数据处理的种类不一样,解决的场景也不一样。最终都会为我们人类文明的发展做出自己的贡献。

甚至于说在未来的20年、50年以后,我们有下一波的增长,这个增长可能比人工智能还要高一个维度,或者说那个时候已经超过了我们所有人现在能理解的东西,或许已经不能用智能去定义了,也许我们能变成五维、六维的生物,到底是什么我们也不得而知。

但是我觉得,人类的文明是滚滚向前的,我们需要各种技术,综合去处理各种各样的问题。

回到向量数据库,虽然说过去几年向量数据库有特别大的增长,但是我也不喜欢说用一个 Buzz word 去说要颠覆谁或者要干掉谁,大家都有很大的发展空间,大家都有不同的甜蜜点和应用场景。

佳芮:我觉得 Charles 是一个非常务实的理想主义者。

Jay:是的,我们聊最后一个问题,我关注到你是一个兼具极客范和浪漫主义的人,你的公司也是。 比如你会一次买几十件相同款式的T恤,然后经常受到售货员关怀的眼光和充满善意的提醒:这些衣服今天不打折。比如你还有冥想的习惯,包括运动,这都非常硅谷。

另一方面,你的名字星爵,这是一个漫威超级英雄的名字,你好像很喜欢银河护卫队。你认为「其他漫威英雄都有一个母星,有一个 hometown,但星爵和他的银河护卫队是把探索广袤的宇宙作为使命。完成一个任务之后,下一个目的地永远是无尽宇宙,他们始终对未知充满好奇。」

25.webp

25.webp

你也把改名字的传统带到了公司,「每一位小伙伴加入的第一件事就是要选一个自己的英雄,可以是历史上真实存在的人物,或者任何一个时空里的虚拟人物。」

我不知道这是不是程序员的浪漫,但站在公司角度,Zilliz 确实是一家非常出色的华人背景的全球领先的科技创业公司,想请你最后和大家聊聊:

Q14:极客范+浪漫主义的文化对企业创新和发展有什么价值?

星爵:本质上来说是我们希望 Zilliz 能够成为一个全球领先的伟大公司。其实刚才您也提到了一本书——《Good To Great》(《从优秀到卓越》),我觉得在从 good to great 的路径上,极客范意味着我们要把所有的事情做到极致,我们希望能够把事情做得更好,所有的事情我们都能去注意所有的细节,然后看看我们能不能做得更好,我们 push to the limit。

浪漫主义我觉得是在从优秀到卓越的路上提供一个心灵上的长期支持。从好到特别好,再到真正的卓越需要特别长的时间,这个过程其实是很痛苦的,路上有很多因素可能都会让人想放弃。如果说有一些人文主义的情怀,有一些浪漫主义的关怀,那么可能你看到今天要把这个功能做出来,要让这个性能再提升五倍到十倍的痛苦的同时,你可以看到诗和远方。就是我们能够到什么地方去?我们如何能够坚持下去?

所以我觉得极客范和浪漫主义,可能是支撑我自己还有我们很多小伙伴,对创新、对企业完成从优秀到卓越的跨越式发展目标背后的一个长期的力量。

我们既务实地在用极客范每天去做一些改进,同时在我们遇到痛苦的时候,让我们能够看到诗和远方,有一个浪漫主义的情怀。虽然今天很痛苦,也许明天会更好,对不对?

刚才讲到我们做的一件特别有意思的事情,就是我们让每一个小伙伴加入公司时选一个英雄,这个英雄可以是一个历史人物,可以是一个虚构小说的人物,可以是游戏里的人物,甚至可以是家里养的宠物,当然也可以是自己的亲人,包括你所有认识的人,反正古今中外虚构的真实存在的都可以。

然后我们不只会让每个小伙伴去选,还会让他去讲为什么要选这个英雄,而这个过程我发现特别有意思。平时我们很多的程序员可能比较内向,不太喜欢说话,但是他们在选英雄的时候,体现出了极高的浪漫主义和人文主义修养。

有选各种游戏里的人物的,有选古今中外名人的,有选世界上著名科学家的,不管是在世的还是以前的,还有选企业的领导人、政界的领导人的,都有。并且大家都有特别多的想法,能讲出来为什么自己喜欢这个人,为什么希望自己成为这个人?

但是我们也许都知道,游戏比如说 Dota 里面的人物,或者是英雄联盟里面的人物是不存在的,我们不可能变成他。所以在选他的时候,大家表现出的就是浪漫主义。这个人可能是总统,这个人可能是马斯克,可能大家觉得也不太会成为他,但是会有这么一个理想主义情怀。

那么这个情怀,或许能够支撑我们每一天让自己变得更好,让我们的产品变得更好,最终通过我们的产品变得更好能够让整个人类的生活、让其他的开发者、让其他的企业变得更好。

佳芮:用诗和远方来缓解当下的枯燥和痛苦,永远对未来充满希望。

星爵:对,其实创业是一件特别痛苦的事情,所以你总归要时不时地走出来,你总归要有一刻把自己从最繁琐的杂事、挑战、困难,甚至是把你逼疯的这些各种奇奇怪怪的事情里面,把自己给拉出来,让自己得到片刻的休息。 佳芮:找到当下的意义,也找到远方的意义。

Jay:对,非常感谢星爵今天非常真实、底层且深刻的同时又能穿越古今,包括对未来的畅想,我觉得都非常精彩,感谢星爵今天的分享。

如果大家认为这期播客有趣有价值,欢迎分享给你认为有需要的小伙伴,也欢迎大家在苹果 Podcast、Spotify、小宇宙、喜马拉雅订阅和收听我们的播客。再次感谢星爵,我们今天就到这里,大家拜拜。

星爵:感谢两位主持人,谢谢。

媒体资源

下载 Zilliz 官方品牌标识及媒体资源

媒体联系